DreaMoving是什么:

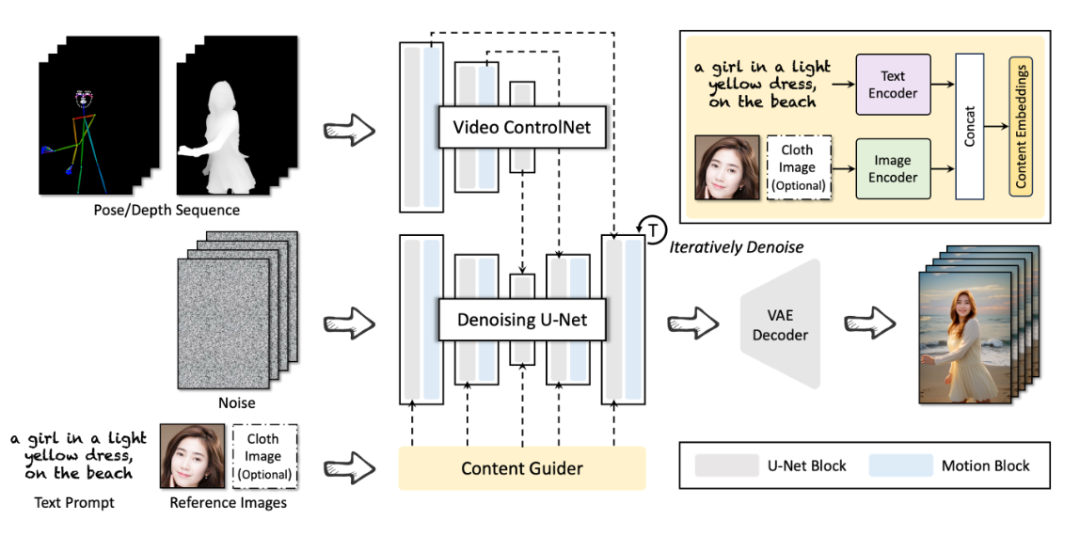

DreaMoving是一个基于扩散模型的可控视频生成框架,旨在生成高质量的定制化人类视频。具体来说,给定目标身份和姿势序列,DreaMoving可以生成目标身份在任何地方跳舞的视频,由姿势序列驱动。为此,DreaMoving提出了一个Video ControlNet用于动作控制,以及一个Content Guider用于身份保持。该模型易于使用,并且可以适应大多数风格化的扩散模型,以生成多样化的结果。

主要特点:

- 高质量视频生成:能够生成高质量、高保真度的视频,给定指导序列和简单的内容描述(例如文本和参考图像)作为输入。

- 身份控制:通过面部参考图像实现精确的身份控制。

- 动作操控:通过姿势序列实现精确的动作操控。

- 视频外观控制:通过指定的文本提示实现全面的视频外观控制。

- 强大的泛化能力:在未见过的领域也表现出强大的泛化能力。

主要功能:

- Video ControlNet:用于动作控制,通过在每个U-Net块后注入运动块来处理控制序列(姿势或深度),生成额外的时间残差。

- Content Guider:将输入的文本提示和外观表达(例如人脸,服装可选)转换为内容嵌入,用于交叉注意力。

- Denoising U-Net:一个用于视频生成的Stable-Diffusion U-Net的衍生版本,包含用于视频生成的运动块。

使用示例:

- 身份控制:给定一个女孩的面部参考图像,DreaMoving可以生成她在不同场景中跳舞的视频,保持身份的一致性。

- 动作操控:通过输入不同的姿势序列,DreaMoving可以生成目标人物在不同场景中执行特定动作的视频。

- 视频外观控制:通过指定的文本提示,如“一个女孩,微笑着,在法国小镇跳舞,穿着浅蓝色长裙”,DreaMoving可以生成符合描述的视频。

总结:

DreaMoving是一个强大的视频生成框架,通过其创新的Video ControlNet和Content Guider,实现了对视频内容的高度控制。它不仅能够生成高质量的视频,还能在身份、动作和外观方面提供精细的控制。DreaMoving的泛化能力使其在处理未见过的领域时也能保持良好的性能,这为视频生成领域带来了新的可能性,特别是在娱乐、教育和广告等行业中具有广泛的应用前景。

津公网安备12011002023007号

津公网安备12011002023007号