OmniParser是什么

OmniParser是由微软研究院开发的一个紧凑的屏幕解析模块,能够将用户界面(UI)的屏幕截图转换为结构化元素。它旨在与各种模型结合使用,创建能够在用户界面上执行操作的智能代理,特别是在只有视觉输入的情况下,如在不同的操作系统和应用程序中作为通用代理。

主要特点

- 多模态模型的补充:OmniParser能够与大型视觉语言模型(如GPT-4V和GPT-4o)结合,显著提升这些模型在用户界面中的操作能力。

- 高性能屏幕解析:该工具能够可靠地识别用户界面中的可交互图标,并理解屏幕截图中各种元素的语义,准确地将预期动作与屏幕上的相应区域关联起来。

- 开源与研究推动:微软将OmniParser公开在GitHub上,并提供了训练过程的报告,以鼓励研究者开发能够在不同应用程序和环境中执行操作的代理。

主要功能

- 创建专业数据集:开发了两个数据集,一个用于检测可交互图标,另一个用于描述UI元素的功能,这两个数据集是训练模型理解检测元素语义的关键。

- 微调检测和描述模型:利用两个互补的模型,一个检测模型用于识别截图中的可操作区域,一个描述模型用于提取检测元素的功能语义,生成准确描述其预期动作的文本。

- 基准测试性能提升:在ScreenSpot基准测试中,使用OmniParser解析结果的GPT-4V性能大幅提升。在Mind2Web基准测试中,OmniParser + GPT-4V的性能优于使用HTML额外信息的GPT-4V代理。在AITW基准测试中,OmniParser超越了使用Android视图层次结构训练的专业Android图标检测模型的GPT-4V。此外,在新的WindowsAgentArena基准测试中,OmniParser也取得了最佳性能。

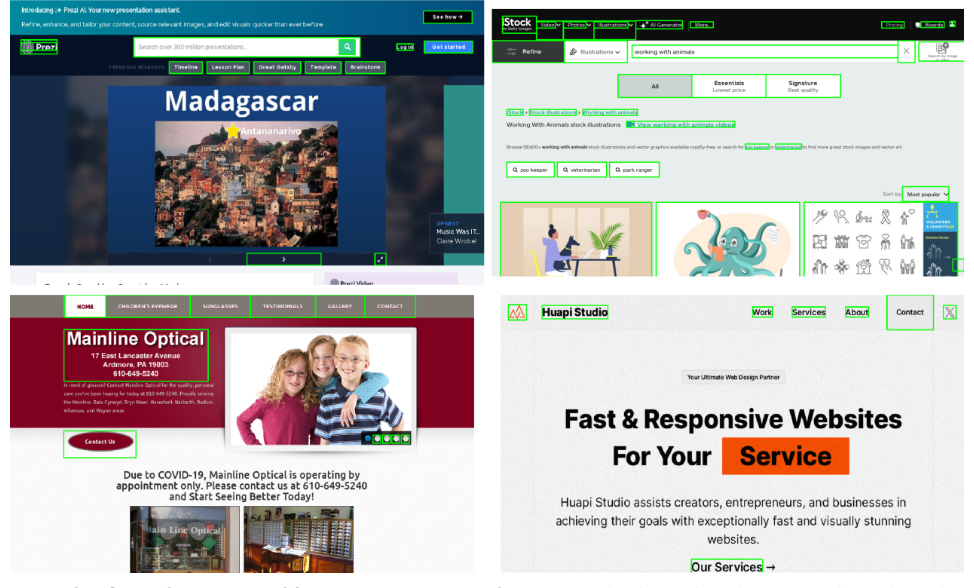

使用示例

以WindowsAgentArena基准测试为例,一个使用OmniParser和GPT-4V的代理在该基准测试中取得了最佳性能。这表明OmniParser能够有效地解析用户界面,并与GPT-4V结合,生成精确的、基于界面区域的操作指令。例如,代理可以识别屏幕上的“发送”按钮,并理解点击该按钮将执行发送消息的操作。

总结

OmniParser是一个创新的屏幕解析工具,它通过与先进的视觉语言模型结合,显著提升了智能代理在用户界面中的操作能力。其主要优势在于能够准确识别和理解用户界面元素,并生成精确的操作指令。微软通过开源OmniParser,为研究社区提供了一个强大的工具,以推动多模态智能代理的发展,特别是在视觉输入受限的环境中。这不仅有助于提升现有模型的性能,也为未来智能代理的开发提供了新的方向。

津公网安备12011002023007号

津公网安备12011002023007号