Vary-toy是什么?

Vary-toy是由MEGVII Technology、University of Chinese Academy of Sciences和Huazhong University of Science and Technology的研究人员共同开发的一款小型视觉语言模型(LVLM)。它旨在解决大型视觉语言模型在训练和部署上的挑战,特别是对于资源有限的研究者。

主要特点:

- 小尺寸:相比于其他大型视觉语言模型,Vary-toy小得多,便于在消费级GPU上训练和部署。

- 功能全面:尽管尺寸小,但Vary-toy实现了与大型模型相似的功能,如文档OCR、图像描述、视觉问答等。

- 强化视觉词汇:通过改进的视觉词汇网络,Vary-toy能够更有效地编码自然物体的视觉信息。

主要功能:

- 文档级光学字符识别(OCR)

- 图像描述

- 视觉问答(VQA)

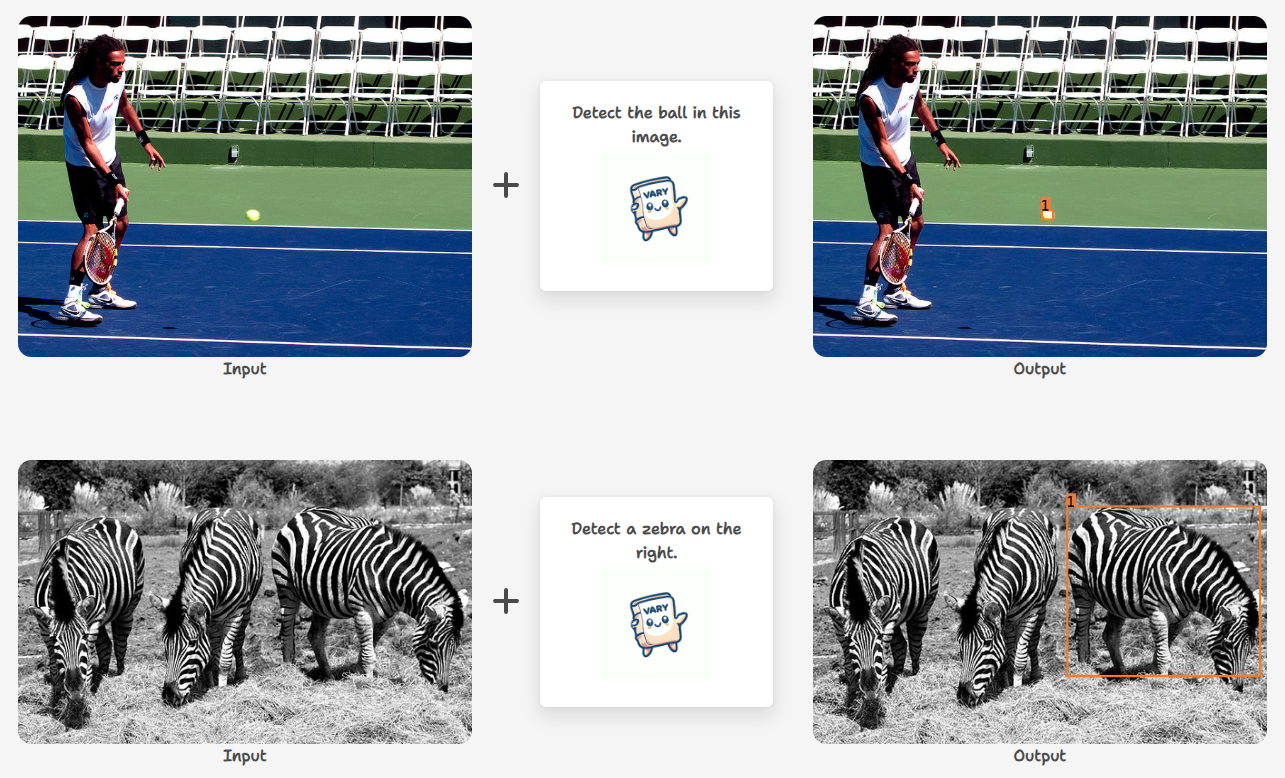

- 对象检测

- 图像到文本的转换

- 多模态对话

使用示例:

- 对象检测:

- 用户上传图片,Vary-toy识别并定位图中的各个对象。

- OCR图像转文本/Markdown:

- 用户上传PDF图像,Vary-toy提供图像中文字的OCR结果,并可转换为Markdown格式。

- 日常对话:

- 用户与Vary-toy进行日常对话,模型理解和生成与图像内容相关的对话。

总结:

Vary-toy是一个小型但功能强大的视觉语言模型,它使得资源有限的研究者和开发者也能体验到先进的视觉语言模型功能。通过改进的视觉词汇网络和多任务预训练策略,Vary-toy在保持小尺寸的同时,展现出处理复杂视觉语言任务的能力。

津公网安备12011002023007号

津公网安备12011002023007号