人工神经网络计算有两个特性,第一是神经网络的预测对计算精度具有一定的包容性,第二是基本上所有的算法,都是以矩阵和向量所组成的不同序列的运算。Google根据这两个特性研发了TPU芯片,也就是张量处理器:通过量化来降低硬件尺寸和功耗,并可以有效压缩模型,同时又能保证可用的精确度。通过MXU的脉动阵列使芯片具有较强的矩阵和向量运算能力,非常适合人工神经网络运算。TPU芯片经过多次升级,已经被应用在其各个产品中,包括 Google 搜索、翻译,还有 AlphaGo,所以李世石和柯洁当时其实是在和整架整架的 TPU 在比赛。

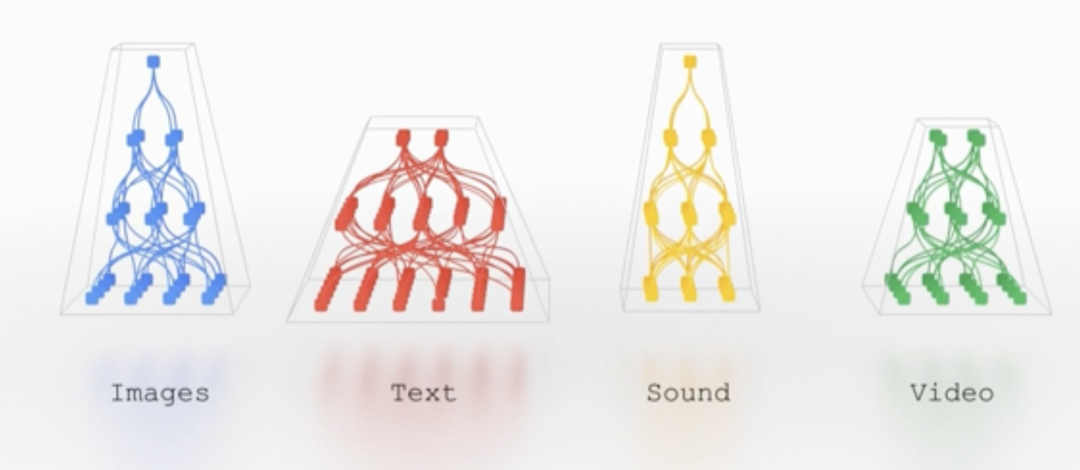

二、目前大部分的模型,只能处理单一型态的资料,影像,或是文字,或是语音,不是同时处理全部。但是人类可以运用所有的感官,去学习、去反应,来决定你该做出什么行为。如果我们也可以用同样的道理来建模型,它可以接收不同类别的数据,包括文字、影像、语音,然后把它们融合在一起,不管这个模型接受到“猫”这个字,还是一部“猫”的影片,或者听到某个人说“猫”的语音,都会产生相同的反应,都能和“猫这”个概念对应上,这样最合理不过了。

再进一步,如果还可以处理其他不同种的资料,甚至是非人为产出的资料,例如基因序列,3D 点云,和影像、文字、影片,就更理想了。

人工智能可以以同样的方式工作。假设我们可以构建一个“稀疏”激活的单一模型,这意味着只有通过网络的小路径在需要时才会被调用。模型动态地学习网络的哪些部分擅长哪些任务——它学习如何通过模型中最相关的部分来路由任务。这种架构的一大好处是,它不仅具有更大的学习各种任务的能力,而且速度更快、能源效率更高,因为我们不会为每项任务激活整个网络。

2021年10月,Google 推出了Pathways,一种可以训练多任务的下一代人工智能架构,可以说是向AGI的方向跨出了一大步。Pathways 将使单个 AI 系统能够泛化数千或数百万个任务,同时处理所有型态的资料,然后把它们融合在一起,并使用零星、高适应力的模型,只在需要的时候用所需的部分,当我们逐渐增加新的任务,它可以同时处理所有资料,并且必要时,会渐渐学习新的任务,然后针对不同的内容,运用与其相关的部分。将我们从仅识别单一用途模型单一模型的时代推进到一个更加通用的人工智能时代。这将是神经网络和人工智能能力的大规模进化和升级。

除了Google之外,一些其他互联网和计算机厂商也在致力于这个方向的研究, 比如微软研究实验室及其投资的OpenAI。

从神经网络到通用人工智能,如果能够实现的这一跨越,建立起能够对世界有更深的理解的通用的智能系统。可以解决更多不同尺度的复杂问题:更准确的诊断出更多疾病;制造出更好的药物;提升教育系统,让大家用全新更好的方法来学习,甚至可能是处理气候变化,清洁能源解决方案这类尺度的难题。

参考:

https://www.nextbigfuture.com/2022/02/174523.html

https://storage.googleapis.com/deepmind-media/A%20Generalist%20Agent/Generalist%20Agent.pdf

https://medium.com/neuromation-blog/deep-learning-and-agi-part-i-computer-vision-b9200d904994

https://www.instructionaldesign.org/theories/general-problem-solver/

上述内容若有错误或不足之处,欢迎大家指出,非常感谢。

津公网安备12011002023007号

津公网安备12011002023007号