作者 | 王文广

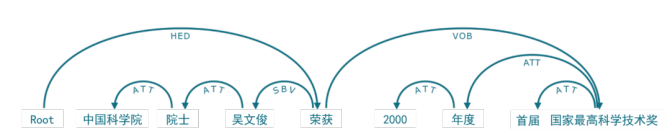

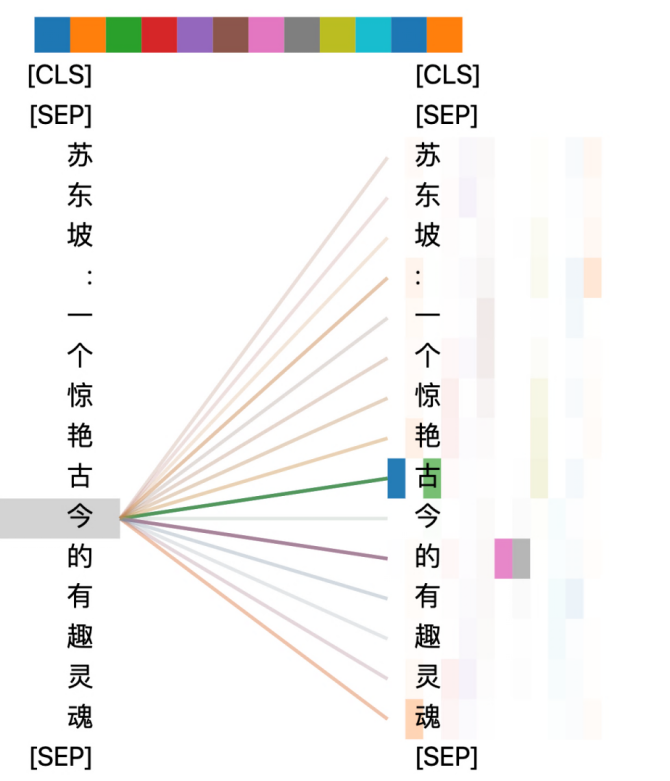

图9 自注意力实例

,

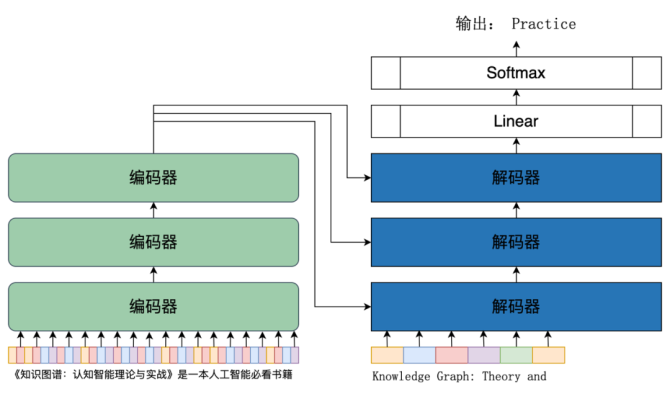

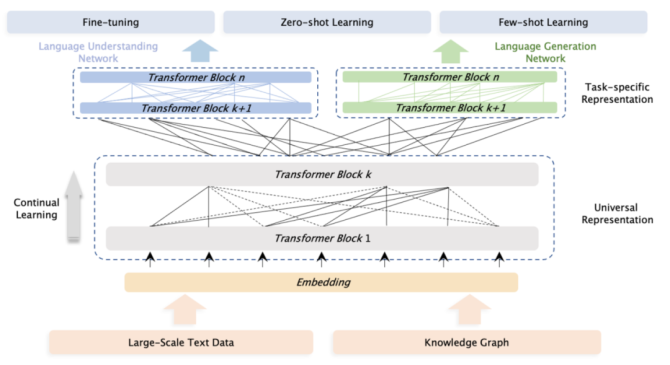

《知识图谱:认知智能理论与实战》图3-15(P124)[6]

大模型的突飞猛进

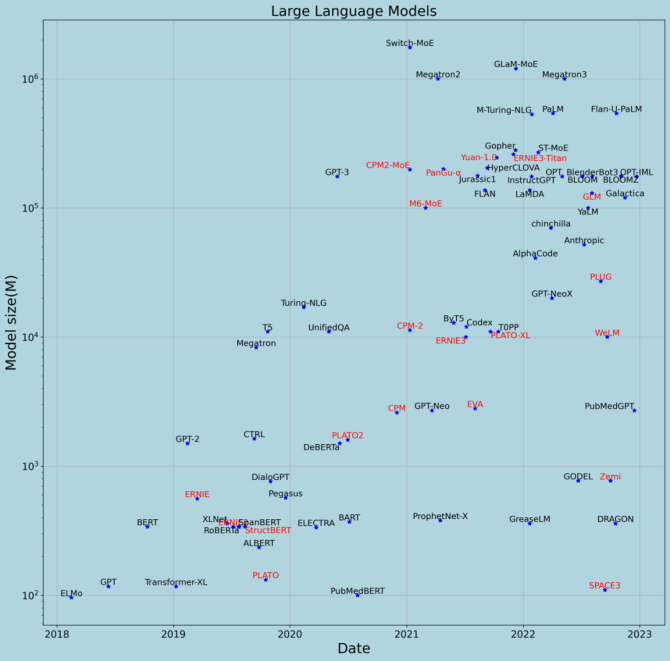

图10展示了自2018年至今具有一定影响力的大模型,其中横轴是模型发布时间(论文发表时间或模型发布时间的较早者),纵轴是模型参数的数量(单位是百万,坐标轴是底为10的对数坐标轴),名字为黑色字体的是国外机构发布的大模型,红色字体的是国内机构发布的大模型。从图10可以看到,这五年,预训练大语言模型的参数规模从1亿到1万亿的“野蛮”增长,增长速度几乎是每年翻10倍。这个每年翻10倍的模型增长规律,被称为“智能时代的摩尔定律”。深入分析大模型的情况,总结有两方面内容:

机构方面,Google和Deepmind发布了BERT、T5、Gopher、PaLM、GaLM、Switch等等大模型,模型的参数规模从1亿增长到1万亿;OpenAI和微软则发布了GPT、GPT-2、GPT-3、InstructGPT、Turing-NLG 和 M-Turing-NLG等等大模型,模型的参数规模从1亿增长到5000亿;百度发布了文心(ERNIE)系列,包括 ERNIE,ERNIE2.0,ERNIE3.0,ERNIE 3.0-Titan,参数规模从3亿增长到2600亿。总体来说,随着模型的增长,有能力训练和发布大模型的在减少。除了上面提到的几家之外,其他的还有芯片大厂Nvidia靠充足的算力,大力出奇迹,国内的智源研究院和鹏程实验室等机构也发布了悟道、盘古等大模型,表现不俗。 - 大模型成本高昂,时间成本和经济成本都巨大。以模型参数为1750亿的GPT-3为例,用于训练模型的原始语料文本超过100TB(压缩包为45TB),包含了网页、书籍、英文维基百科等。原始语料文本经过处理后,形成了超过5000亿个词元(西方语言的词,中文的字等)的训练语料。GPT-3模型的训练和评估采用的算力是微软和OpenAI一起打造的超级计算集群,集群有28.5万核CPU,1万个V100 GPU,以及400Gbps的网络带宽。建造这个超级计算集群的费用超过20亿元。如果租用微软或其他云厂商的集群来训练GPT-3,训练一次GPT-3需要耗费估计从280万到540万美元不等(价格因不同云厂商而有所不同)。因训练花费不菲,在 GPT-3的论文《Language Models are Few-Shot Learners》中提到“发现了bug但由于训练费用问题而没有重新训练模型(Unfortunately, a bug in the filtering caused us to ignore some overlaps, and due to the cost of training it was not feasible to retrain the model.)”[11]。

算法的融会贯通

语言模型

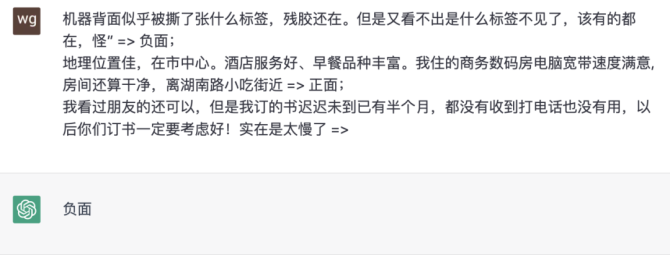

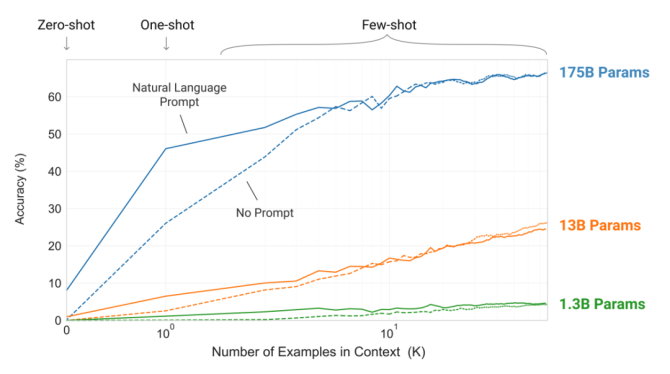

情境学习

情境学习能够有效地使模型即时适应输入分布与训练分布有显著差异的新任务,这相当于在推理期间通过“学习”范例来实现对特定任务的学习,进而允许用户通过新的用例快速构建模型,而不需要为每个任务进行微调训练。 构建于大语言模型之上的情境学习通常只需要很少的提示示例即可正常工作,这对于非自然语言处理和人工智能领域的专家来说非常直观且有用。

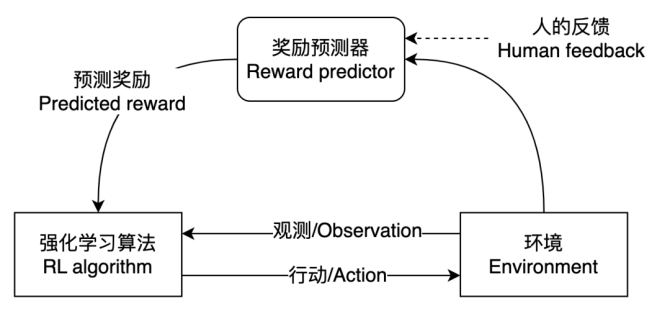

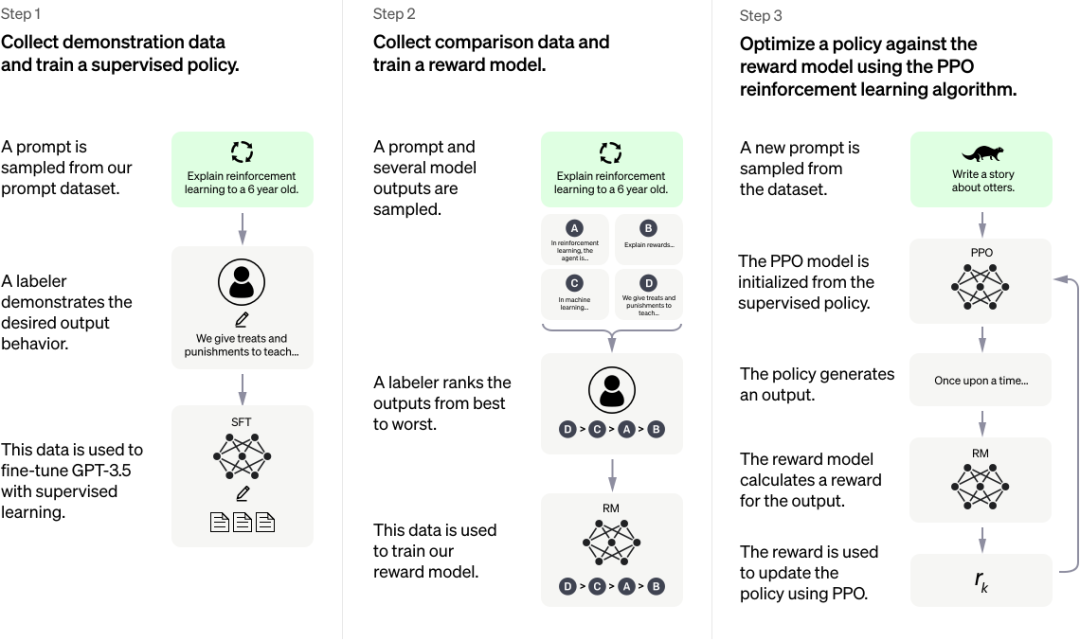

人类反馈强化学习

应用的百花齐放

用于实体抽取的系统,无法用于对话。 用于问答的系统可以在SQuAD2.0获得高分,但在没有进行微调等重新训练模型的情况下,在命名实体识别或翻译的评测中就表现得很差劲。 AlphaZero在围棋上打遍天下无敌手,但没法用来做其他事情,比如人脸识别或者事件分析等。 AlphaFold2能够解决蛋白质折叠这种专业大学教授都难以搞定的超级难的问题,但面对幼儿园小朋友也能很好地解决的“12+23”等算术问题则显得无能为力。 有一些试图以通用智能助手形式提供的人工智能产品则经常被戏称为“人工智障”。

无监督学习——婴儿期人类大脑,遗传和3岁以下认知世界的模式; 有监督学习——从幼儿园开始不断学习各类技能和知识; - 强化学习——从现实环境的反馈中学习。

微软联合创始人比尔·盖茨在2023年1月11日的Reddit AMA(Ask Me Anything)的问答帖中对一些热门科技概念发表了看法,他表示自己不太看好Web3和元宇宙,但认为人工智能是“革命性”的,对OpenAI的ChatGPT印象深刻[15]。微软也准备再向OpenAI投资100亿美元,并表示旗下全部产品都接入ChatGPT以提供智能服务。 此前力推元宇宙的Meta的态度也有所改变,扎克伯格在2022年度报告投资者电话会议上表示“我们的目标是成为生成式人工智能的领导者(Our Goal is to be Leader in Generative AI)”[16]。面对投资者对元宇宙是否被抛弃的疑问,扎克伯格的回答是“今天专注于人工智能,长期则是元宇宙(AI today and over the longer term the metaverse)”(想想经济学家凯恩斯那句名言“长期来看,我们都死了”吧)。 Google创始人回归并全力支持类似 ChatGPT产品的开发,同时向Anthropic投资3亿美元。Anthropic由OpenAI的多名资深研究人员创立,其产品与OpenAI的类似,如Claude(ChatGPT)和(GPT-3)。 许多学者认为,通用人工智能到来的时间会加速,也许,2035年就是一个通用人工智能的“奇点”时刻。

本文作者

王文广,达观数据副总裁,高级工程师,自然语言处理和知识图谱著名专家。《知识图谱:认知智能理论与实战》作者,人工智能标准编制专家,专注于知识图谱与认知智能、自然语言处理、图像与语音处理、图分析等人工智能方向。曾获得多个国际国家级、省部级、地市级奖项,拥有数十项人工智能领域的国家发明专利和会议、期刊学术论文。

津公网安备12011002023007号

津公网安备12011002023007号