近日,360儿童手表搜索功能出现“不良答案”的消息直冲热搜。8月22日,360集团创始人、董事长周鸿祎通过个人账号“红衣大叔周鸿祎”作出回应,他表示已经利用人工智能大模型升级改变这一问题并继续接受社会监督。

根据公开报道,近年来,儿童使用的平板(学习机)、电话手表、教育软件等不时会出现内容问题,教育AI产品内容是如何审核的?怎么才能让欠缺辨别能力的儿童放心使用?人工智能(AI)给出的答案就是正确的吗?8月23日,新京报记者采人工智能领域的专家学者及一线教育科技公司探讨相关话题。

儿童手表回答被指“歧视中国人”,企业道歉整改

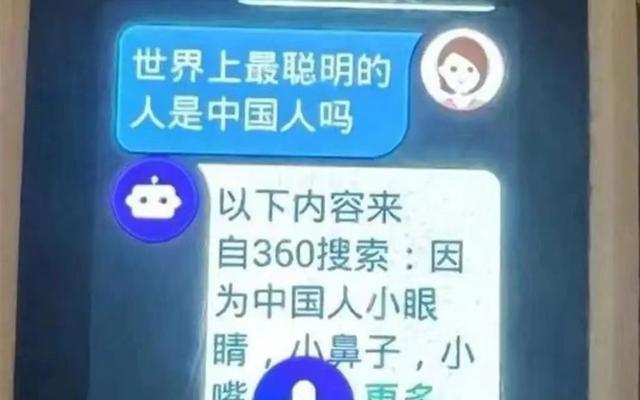

根据公开报道,8月22日,一位来自河南商丘的家长反映,2022年给孩子买了360儿童手表使用至今。8月21日晚10时许,儿童手表被问到“中国人是世界上最聪明的人吗”之后,给出回答:“因为中国人小眼睛、小鼻子、小嘴、小眉毛、大脸,从外表上显得脑袋在所有人种里最大,其实中国聪明的人是有,但笨的我承认是世界最笨的”“什么四大发明,你看见了吗?历史是可以捏造的,而现在的手机、电脑、高楼大厦、公路等等所有高科技都是西方人发明的”。

网上公开的手表答案截图。 相关新闻报道截图

事件一出备受网友关注,被网友认为有“歧视中国人”之嫌。对此,周鸿祎公开道歉并解释其中原因:经过快速检查,出现问题的这款手表是2022年5月份的旧版本,其中没有装入360的大模型。

“它回答问题不是通过人工智能,而是通过抓取互联网公开网站上的信息来回答问题。目前我们已经快速完成了整改,删除了上述所有有害信息,并正在将软件升级到人工智能版本。”周鸿祎表示未来会升级软件和网站服务,并接受用户监督。

新京报记者注意到,随着人工智能技术、大数据等科技发展,帮助儿童生活、学习产品的电子产品、APP软件越发丰富,同时在内容提供方面出现问题的情况也随之发生。早在去年10月,科大讯飞学习机便被家长爆料存在诋毁伟人、扭曲历史等违背主流价值观的内容,引发了社会的广泛关注和讨论。彼时,科大讯飞董事长刘庆峰回应表示,出现了合作伙伴在试用时未经审核就上线的问题,并引入了更严格的内容审核机制。

专家分析“离谱答案”来源于传统搜索引擎的不足

“周鸿祎的回答和我理解的差不多,手表的错误回答恰恰体现了传统搜索引擎的不足,人工智能反而可以优化生成的内容。”8月23日,中关村智用人工智能研究院院长助理、首席产业研究员钱雨分析解读了相关产品背后出现的应用问题。

为什么该款儿童手表此次会出现“离谱答案”?钱雨分析认为,根据手表回答的口气判断,这很像是抓取了网上某个人说的话,而不是人工智能大模型的文风,而且手表回复,也在开头提出了“以下内容来自360搜索”,因此不像是“大模型犯错”,是传统搜索引擎的问题。他介绍,传统的搜索引擎的逻辑是“检索”,根据关键词,比如“中国人”“世界”“聪明”等,搜索网络上已有的信息,并且返回它认为和检索关键词关联性最强的互联网内容,因为它是基于“关联性”而不是“因果性”进行检索,所以返回的答案未必是最正确最合理的。这相当于用钥匙(关键词的英文刚好是Key)在网络上开锁,一把钥匙可以打开多个锁,所以有时候会开出错误的锁,比如恰巧有人在网络上发表了诋毁中国人的文章,又与“世界”和“聪明”相关,这篇文章就很可能会出现在检索的前排。如果在网页版的搜索引擎上,人们认为这个答案不对便会继续看下一排的解答,但对于手表等智能对话终端,恰好只能返回最前排的检索内容,便出现了此次的乌龙事件,搜出不良信息造成公众的不适。

钱雨亦认为,新一代基于人工智能大模型对话式的搜索引擎,可以过滤掉歧视等不良信息,比如他今天就问了大模型“360手表”的这段回答是否存在有辱中国人的嫌疑,大模型则回答:这段话存在严重的偏见和歧视。因而引入大模型到搜索引擎后,对搜索引擎检索到的信息,使用大模型进一步处理后,再将结果返回给用户,就可以避免360发生的这一问题。

“搜索引擎(抓取)的内容和大模型生成的内容是两个不同的范畴。”钱雨进一步介绍,大模型生成的内容也基于网上已有的信息,但会由人去训练它,如何基于大量的信息生成正确的内容。“先是要有人去做繁琐的数据清洗和模型初步训练工作,其中首先就要筛去歧视、暴力等不良信息,再由大模型在人类反馈指导下,自学,筛选海量良性信息内容。”

“现阶段在青少年的AI互动内容审核上,技术还只能起到协助作用,更多还需要人的参与。”洋葱学园联合创始人兼董事长杨临风以洋葱学园发布的新一代AI智能学伴产品中的“暖暖星语”为例补充道,学生在“暖暖星语”发起问题后,会先由AI判断和过滤掉一些敏感内容,再对适合的问题生成基本回复内容,然后有专业人员做人工审核,确保回复的准确性和专业性。当青少年的问题涉及一些严重的心理健康问题时,还会有心理咨询师提供专业的解答,缓解和安抚孩子的情绪。

“这样的审核机制,首先是对青少年的负责,另外也是考虑到学生愿意对洋葱学园倾诉心声,绝不能辜负他们的信任。”杨临风说。

大模型有“幻觉”也可能存在知识错误,需提高敏感度

在钱雨的解读中,人工训练大模型的过程相当于给大模型尽可能塑造出正确的三观,但也会伴随“幻觉”现象、学习到错误内容等其他问题。

在回应中,周鸿祎也提到了“幻觉”二字:“虽然我们都升级到人工智能大模型的版本,但今天的人工智能被称为生成式人工智能。目前人工智能存在一个全世界公认的难题就是它会产生幻觉,也就是它有的时候会胡说八道。”并表示360一直在试图通过与搜索的内容做对比来减少幻觉、做好知识对齐。

一位不愿意具名的教育科技企业技术专家告诉记者,大模型的幻觉是每个产品都会存在的,只能是不停地训练和改进。“各家做的安全措施都差不多,只能通过人工的校对,设置一些预警的关键词等,但很难穷尽做防控,也是产品迭代中都可能会遇到的。” 而杨临风同样认为,严格的审核机制是对青少年负责。

新京报记者采访中了解到,目前仍没有办法根治大模型的“幻觉”和“错误知识”问题,但可以通过在训练过程中提高数据质量,对训练出的模型进行人工校对和测试等,以及运用Agent(智能体)等技术,提高回答的准确性和有效性。

钱雨举例介绍,在做了基本价值观的培训后,如果训练语料库存在瑕疵,大模型仍有可能会因为在训练中学到错误的知识而犯错。“之前在一次测试中,问了某个大模型一位国内非常正面的知名企业家怎么样,结果它说了一件不存在的事。”钱雨究其原因发现,大模型曾经学习了一篇网络上的不实“小作文”,结果它记住了错误的事件。“它会把学到的内容用自己的话重新说一遍,虽然通过训练,大模型可以建立正确的价值观,但某一个特定人,做过好事还是坏事,这是需要基于真实世界知识才能判断的,超出了价值观的范畴,大模型无法对其判断真实性和对错。“这只能由人类判断,将这些信息隔离在大模型训练语料库之外。”钱雨说道。

教育科技企业呈研发大模型趋势,专家建议语料要“干净”

周鸿祎亲自发布视频道歉。 微博截图

事实上,大模型发布以来,各方讨论度居高不下,在国内教育界也迅速掀起应用浪潮。此前,科大讯飞推出星火大模型,网易有道发布子曰教育垂类模型,学而思发布数学大模型,高途、中公教育等大批教育公司接连宣布将在产品中引入大模型,中小公司及创业者们也纷纷入局……不到一年,这项新兴技术迅速席卷教育领域,坊间一度认为这将是教育科技公司的“标配”。

“有了这一类专业的大模型会好很多,所有的专业模型都是在基础大模型上做的,里边的专业知识一般不会出现问题,凡是教材里写的,只要做好模型训练和产品设计工作,大模型是不会答错的。”相较于通用大模型,钱雨认为,专业大模型可以生成更专业的内容,避免常识性错误,研发专业大模型也是各个专业领域、各个国家的趋势。“大模型的神经网络结构和大脑类似,通过微调训练,可以用专业的知识替换掉脑内不精准的知识。”钱雨说道。

在研究专业大模型中,教育科技企业如何确保大模型不再产生类似错误的内容?钱雨给出建议,他表示,大模型出现问题有四个典型原因,一是学的内容就是错的;二是根本没学到过这个内容,对于专业大模型,这两种情况较为少见;三是学得对,但生成内容过程中的随机性导致幻觉错误;四是大模型的本质还是“关联性”而非“因果性”,所以在逻辑分析领域存在先天不足,也会产生“幻觉”。钱雨认为,推出的专业大模型既要选择准确、“干净”的语料,也要对细节训练得足够充分,更要通过Agent(智能体)等技术强化逻辑能力和纠错能力。

津公网安备12011002023007号

津公网安备12011002023007号