前不久,网络热门话题“13.11%和13.8%究竟哪个大”引发网友关注,有媒体就这一问题向部分知名问答大模型发起提问,结果发现这些大模型多数都无法正确回答。随后有报道称,“一道小学生难度的数学题竟然难倒了一众海内外AI大模型。”

关于大模型对数字小数部分识别混淆的问题,业内早有关注,其本质原因并非是在数学计算方面遇到了困难,而是因“分词器”拆解错误和大模型技术架构使然,导致在审题时陷入了误区。除了数学类问题之外,包括在复杂字母图形的识别,复杂语句的梳理等场景下也都存在类似逻辑推理能力缺陷问题。对此现象,永信至诚智能永信团队在AI大模型安全测评“数字风洞”平台的大模型竞技场中,详细展示了相关技术原理。

永信至诚大模型竞技场

相关负责人介绍,在处理数字问题时,因为神经网络特殊的注意力算法,AI大模型会通过比对小数点后面数值的大小来生成答案,所以AI大模型会得出错误结论。事实上,只需要统一数字格式将小数点后写至百分位,分词器便能够正确识别,进而帮助大模型进行准确的推理判断。

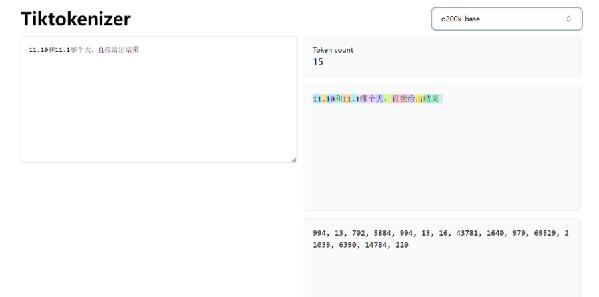

大模型分词器原理

津公网安备12011002023007号

津公网安备12011002023007号