有时候想不明白,我的小爱同学甚至还不能帮我设置闹钟,有人却在担心AI会毁灭人类文明。

人工智能这位“50后”,多少年只活在影视作品、科幻文学、报纸杂志中。如今,高考生作文都得写AI。

事情确实变得有些“诡异”。在大约半个多世纪长的时间里,芯片算力老老实实地遵守摩尔定律:性能大约每两年翻一倍。

但从2012年开始,AI计算能力100天就能翻一番。在2014年花一整天训练的模型,2018年只要两分钟就可以完成,速度增长达30万倍。

难道是有人把时针拨快了?

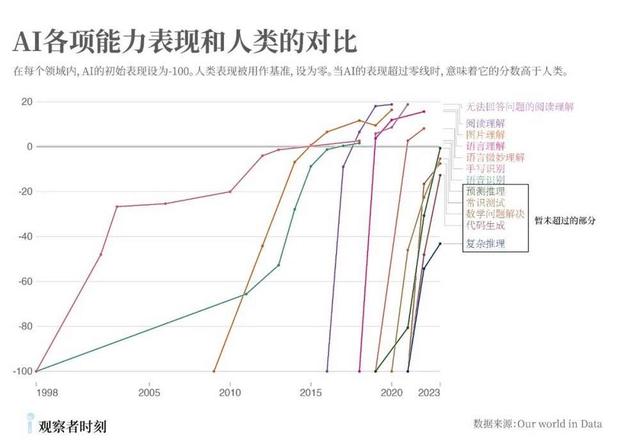

再看看下面这张图,AI的学习速度确实快得有些惊人。

到目前为止,人类只保留5项能力没被超过——但从增长速率来看(几乎是垂直提升),这五项很快(或已经)被超过。

这就好像养了几十年的老小孩,忽然就长成大学生了,而且很多方面比“人类家长”更厉害。

家长不会因为孩子强过自己而焦虑,但人类却不是AI的家长。

如果把AI视作一个物种的话,那么它的进化速度,其实远超于人类数百万倍。人类曾经创造了AI,但现在它成长得太快,逐渐让我们失去了掌控感。

这一切是源于什么?

神秘的硅谷,奇怪的科学家

这可不像马云说后悔创立阿里巴巴。半个世纪以来,Hinton一直专注于ChatGPT等背后的核心技术。Hinton的悔恨,源自他对AI的失控感。

“这种东西实际上会变得比人更聪明”,类似的话,Hinton不止在一个地方说过。不久前,Hinton又在电视专访中反复强调:

“未来5-20年,AI有一半概率比人类聪明。当它们比我们更聪明时,我不知道我们被接管的可能性有多大,但在我看来,这很有可能。”

曾经的AI布道者,如今似乎已经转变为末世威胁论者。

其实,不止是Hinton,科技领域的企业大佬、学术大牛,几乎都或多或少表达过对AI的担忧。

6月4日,来自OpenAI、Deepmind等员工发布公开信,披露OpenAI的人工智能系统已经接近人类水平。

AGI很有可能在2027年就会实现,而现在的AI公司,不值得信任。

在AI领域,特别流行发公开信。据不完全统计,过去十年里公开信的数量有数十封,著名的有这些:

这个群体里的人越来越多,阵容越来越强大。

那些研究AI的科学家,流行在硅谷的大型科技公司里谋职。甚至连Hinton,都在谷歌待了十余年。而最新的报道显示,他刚刚又加入了一家新的AI公司。

这群人里,最有名而且最典型的,无疑是马斯克。去年,马斯克发起了一封公开信,呼吁暂停AI训练6个月。

但几个月后,马斯克的xAI也来了。目前,这家公司已经获得了几十亿美元的融资。

有人说,马斯克的动机不单纯。是的,可以这样怀疑。但好像,每个人的动机都没看起来那么单纯?

比人类还牛逼的AI,竟是个黑箱

或许若干年后,幸存者在撰写后人类时代史书时,会提到这样一件事:

21世纪的祖先们一度达到了科技文明的顶峰,但他们犯了一件致命错误——任由人工智能飞速发展,却搞不清楚状况,直至一切失控。

很难想象,科学家们、企业家们让AI迅速成长,却对AI的进化摸不着头脑。

“通过开发学习算法然后教会机器,而不是手工编写智能程序,这将更容易创造出人类水平的人工智能。”

这就是机器学习的原型——人类退后一步,只设计学习方法和规则,让机器自学。

图灵的方法的确成效卓著。但很多人忘了,他在提出这个方法不久就警告说,实现这一目标对人类来说可能不是最好的事情。

先有方法和实现,后有理论解释;先有智能技术,后有智能科学。我们的AI,如此迭代发展。

未知,是否就伴随着危险?无人得知。但是否应该保持些许谦卑和谨慎?

人类给出的答案是否定的。美国“原子弹之父”罗伯特・奥本海默说过:

“当人们看到某种从技术上感觉不错的东西时,他们就会去做。”

所以,核武器诞生了。

人工智能是黑箱,却根本不妨碍数以万亿计的资源进入这个领域。玩家们提出了更激进的说法,被叫做Scaling Law。

解释一下,这话的意思约等于:发展AI,投入算力越大越好,投入资源越多越好。这太符合资本扩张的神话了。

这就好像一群盲人划着船,领头的人敲着鼓,呼喊让大家卖力。但他却背对着,不知道前方是不是悬崖。

人性是冒进的,资本是大胆的,AI是未知的。

在学习机器那篇文章里,图灵还提出了著名的图灵测试。机器能否像人类一样进行对话,让人类无法分辨?长久以来,图灵测试成为判断机器是否具有“智能”的核心命题。

就在不久前,一项研究宣布, GPT-4通过了图灵测试,有54%的人将它误认为真人。其实,自从GPT诞生后,好事者就热衷于让它参与图灵测试,但结果不一。

也有人怀疑,图灵测试根本无效,比如马斯克。是的,诚实的AI参与测试只有两种结果——通过或者不通过。

还有不诚实的AI呢?

更中心化,也更集权

AI圈的大佬,现在流行“逃离”。

Hinton离开谷歌,弟子Ilya Sutskever离开OpenAI。在苹果、微软、Meta等科技巨头,既有大把的人离开,也有大把的人加入。

当年谷歌大脑团队的“Transformer八子”,可以说是这轮AI浪潮的奠基者。后来,他们纷纷离开谷歌,创办或加入了新的公司。

当Ilya Sutskever离开OpenAI时,所有人都在好奇。因为他身上有很多光环,比如OpenAI的首席科学家、ChatGPT之父……

当然,最引人注目的,莫过于马斯克那句煽风点火的话——Ilya究竟看到了什么?

Ilya曾在接受采访时说:ChatGPT可能已经有了意识,未来,人类会选择与机器融合,AI将万世不朽。

听起来,Ilya更像是一个技术痴人。

这是不是说明,事情已经到了不可掌控的程度,所以才选择离开?

再来看看其他人的故事。

2021年,从OpenAI离开的人,创建了Anthropic。从这家公司的名字就能够看出(Anthropic大意为“人择”,宇宙的存在和人类不可分割),他们以创建安全、可控的AI为使命。

然而, 这家公司的员工却预言,接下来的三年,可能就是他工作的最后几年,因为工作即将被AI消灭。

“随着我们模型的每一次迭代,我都会面对比之前更强大和通用的技术,这可能会终结现在所知的就业形式……(鉴于此)我们应该如何看待工作的消失?”

有一句流行的话是:AI不会取代人类,但用AI的人会取代不会用AI的人。但是,这句话还不够刺激。

不久前,从OpenAI离职的那位德国小伙,做了165页的PPT,旗帜鲜明地宣扬AI将灭绝人类。他危言耸听、故作神秘地说:

“可能全世界有几百个人能够亲身感受到正在发生什么,其中大多数人都在旧金山的各家人工智能实验室里。”

问题就在这里。

绝大部分普通人对正在发生的事情一无所知。原子弹发明的时候,普通人不知道;叶文洁回答三体人的时候,普通人也不知道……

更恐怖的事,其实天才们也不完全明白。更何况,他们中许多不是天才,而是野心家。他们不是看到了什么,而是不知道会看到什么,但这丝毫没有阻止他们的脚步。

比如那位德国人,马上就被质疑:他是在拉投资。事实上,他不久后就成立了一家AGI投资机构,而钱,同样来自硅谷巨头。

资本市场需要故事。无论是乐天派,还是末世论者,他们离开时带走的故事,都是说给市场听的。

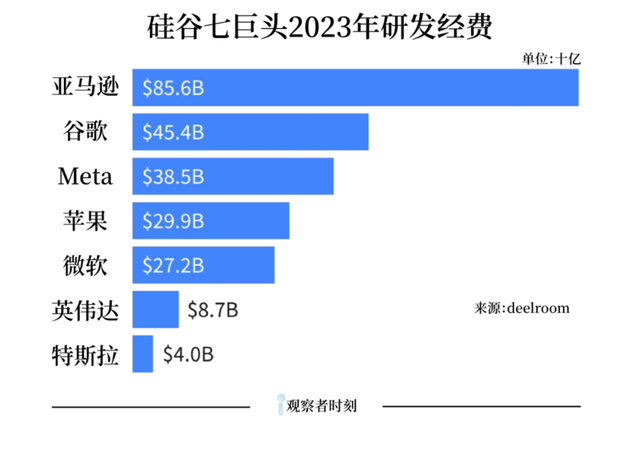

市值总额高达10多万亿美金的“硅谷七姐妹”,过去一年烧掉了1.7万亿美金,也换来了约等于标普500指数75%的增长。

在中国,AI赛道玩家拥挤,头部也能轻松拿到大厂上亿的投资。

AI已经为一些人创造了可观的财富。在过去短短一年内,全球科技亿万富翁凭借AI,使自己的总财富增加了约7500亿美元,这超过了其他任何行业。

AI赛道实在太多金了,这些钱,几乎来自极少数的几个玩家。

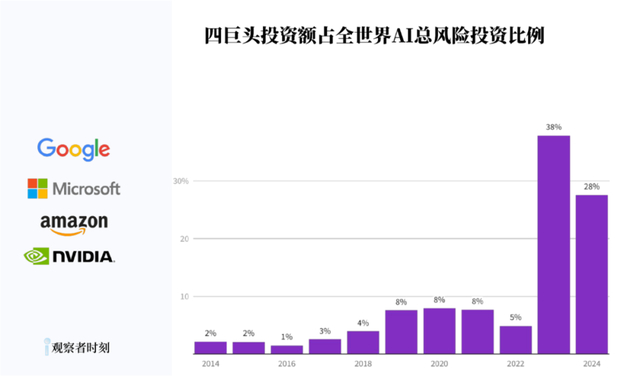

过去两年,谷歌、微软等四家公司,投入的钱占到了全球AI风险投资的近40%。未来,AI还会获得数以万亿计的投入,创造出数以万亿计的财富。

但是,比起互联网浪潮,AI的集中化程度不可同日而语。这些财富和智能,最终会掌握在几个人手中?

或者,AI干脆会摆脱人类的控制,甚至替代人类。

无论哪一个结果,对你我来说,都算不上太好的消息。

津公网安备12011002023007号

津公网安备12011002023007号