AI会因为幻觉(AI Hallucinations)而胡说八道这件事,已经是当下AI行业的共识。无论国内的文心一言、Kimi、混元,还是海外的ChatGPT、Gemini,答非所问、前后矛盾,乃至胡编乱造的现象也早已见怪不怪。为了解决这个问题,作为业界领头羊的OpenAI拿出了新武器。日前OpenAI方面宣布基于GPT-4推出新模型CriticGPT,主要用于捕捉ChatGPT代码输出中的错误。

OpenAI方面透露,通过CriticGPT的帮助,在基于人类反馈的强化学习(RLHF)领域里,人类训练师的审查效果比没有获得帮助的人强60%。OpenAI表示,正在着手将类似CriticGPT的模型集成到旗下RLHF标记流水线中,为自己的训练师提供明确的AI帮助。但同时他们也承认,CriticGPT的建议并不是全都正确无误,但有了CriticGPT的帮助,人类训练师的效率会大幅提升。

众所周知,OpenAI旗下的ChatGPT之所以会表现出比以往AI产品更强的智能,RLHF是其中的关键,它可以借助人类反馈信号来直接优化语言模型,数据标注人员则通过给大模型产出的结果打分,由他们来负责判断大模型生成的文本是否符合人类偏好。如此一来,在RLHF训练中给AI的输出挑错的CriticGPT,实际上就让OpenAI做到了通过人工智能来修正人工智能,等于是左脚踩右脚上天。

事实上,CriticGPT应该是OpenAI去年推出的AI文本检测器(AI Text Classifier)的升级版。检测互联网上的内容是否由AI生成,这已经是目前的一个热点项目,当时OpenAI就拿出了AI文本检测器,但这个工具的效果却不太尽如人意。根据OpenAI方面公布的相关数据显示,AI文本检测器在识别AI生成文本方面的正确率仅有26%,同时将人类所写内容识别为AI生成的错误率则达到了9%。

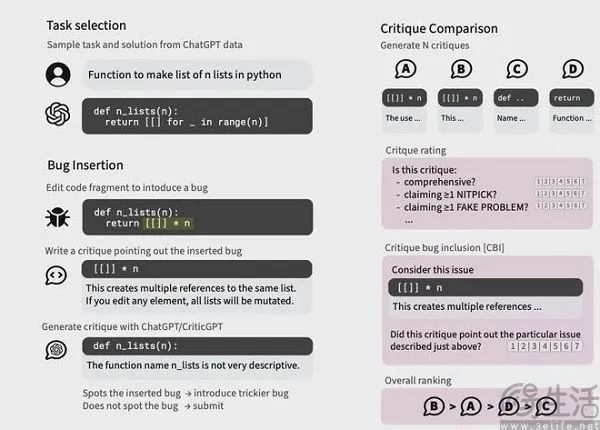

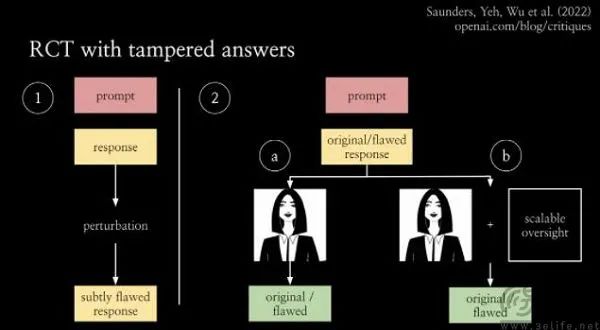

虽然同样使用了监督学习的方法,但AI文本检测器最大的问题就是数据集有限,而想要让一款AI检测工具的性能在线,就需要有一个接近训练ChatGPT所需的数据集。现在基于GPT-4的庞大数据集,CriticGPT诞生了。同样是使用了RLHF,CriticGPT与常规GPT最大的区别,在于训练数据中包含大量有意为之的错误输入,OpenAI称之为通过篡改答案实现的随机对照实验。

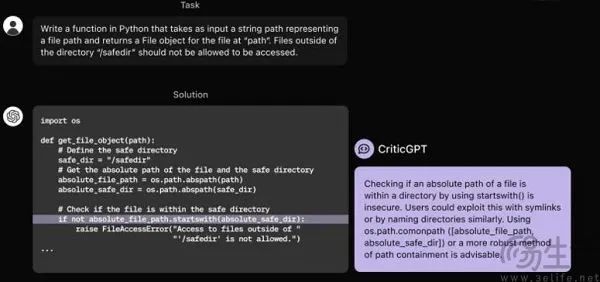

OpenAI方面是先让人类标注员在ChatGPT生成的回答里故意植入错误,然后再指出问题,最后将所有数据交给CriticGPT。不过他们也承认CriticGPT会出现幻觉,如果只是用AI检测AI,考虑到幻觉的存在,两个会产生幻觉的AI大模型碰撞在一起显然只会诞生更大的错误。为此,OpenAI还搞出了名为强制采样束搜索(FSBS)的技术,后者会强制CriticGPT生成多个不同的评论片段,并用奖励模型(Reward model)对这些片段进行评分,最后再根据评分和一个长度修正因子来选择最佳的反馈组合。

如此一来,CriticGPT就可以在输出的全面性和准确性之间找到最优解。以当下最热门的代码生成为例,OpenAI给出的成绩无疑是让人欣喜的,在发现人为有意插入的BUG上,人类审核员平均只能找到25%,而CriticGPT的识别率则达到了75%以上;而在评估自然出现的BUG时,有63%的情况下人类训练师更倾向于选择CriticGPT、而非人类程序员的结果。

即便在评估非代码任务时,CriticGPT也成功识别出了数百个在ChatGPT训练数据中,被人类标注员认为是”完美”、但实际上是错误的结果。至于为什么CriticGPT能实现这样表现,用OpenAI开发者的话来说,对于很多任务来说,评价任务其实比把任务做好要容易得多。相比于ChatGPT,CriticGPT没有创造力,它只能根据已经有的输出进行评价。

CriticGPT的成功不仅仅在于有了一个能用的AI检测工具,更重要的是为后续大模型的训练也提供了帮助。

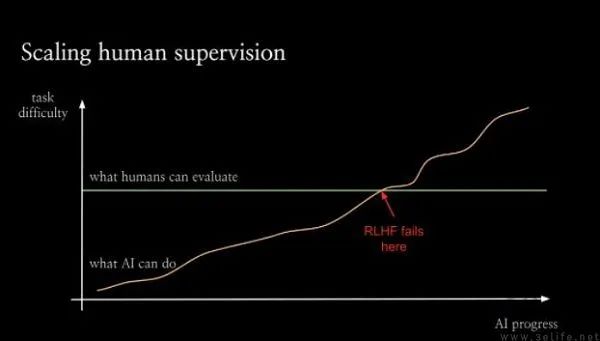

要知道,RLHF是ChatGPT这类大语言模型乃至多模态大模型的理论基础,但RLHF并不是万能的,RLHF的上限就是人类智能的上限。没有CriticGPT的成功,大模型的边界就是人类认知的边界,从某一个临界点开始,人类将无法再可靠地评估人工智能系统,这也是为什么OpenAI去年总是避谈GPT-5。

CriticGPT的出现,就代表着OpenAI提出的可扩展监督(Scalable Oversight)并非妄想。可扩展监督即在确保模型能力超过人类水平后,仍能与人类的期望保持一致、持续地进行改进和学习,或许只有用大模型来监督大模型,才能出现超越人类智能的人工智能。

津公网安备12011002023007号

津公网安备12011002023007号