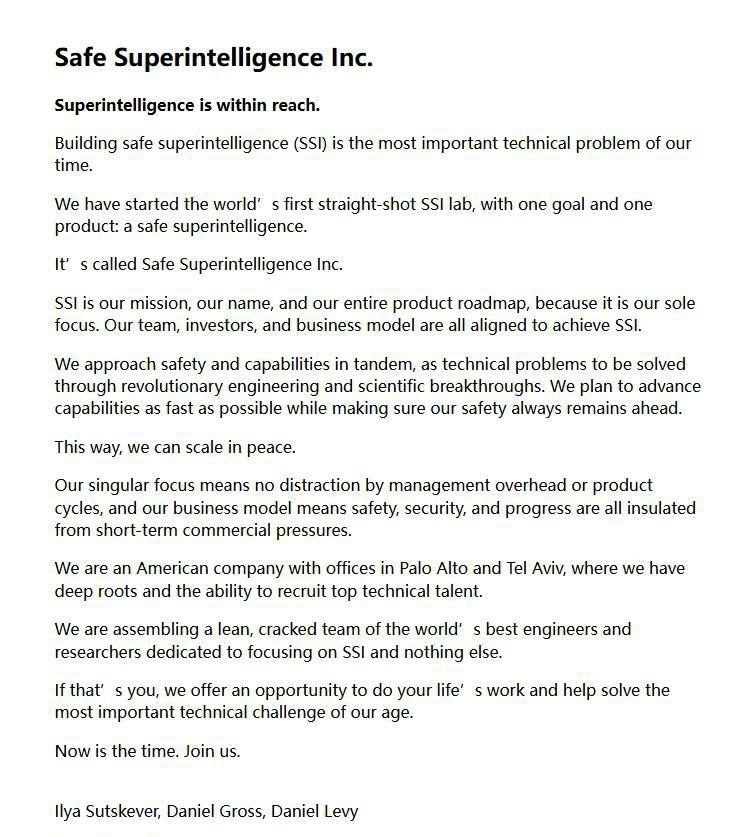

当地时间周三,伊利亚 · 苏茨克维(Ilya Sutskever),OpenAI 的联合创始人兼前首席科学家,在离开 OpenAI 后,正式宣布了单飞后的新 AI 创业项目——” 安全超级智能 “(Safe Superintelligence,简称 SSI).

安全的超级智能

苏茨克维他与前 OpenAI 员工 Daniel Levy 和 AI 投资者兼企业家 Daniel Gross 共同创立了这家初创公司。

据公告称,SSI 为一家 ” 将安全和能力同步 ” 的初创公司,公司将快速推进其人工智能系统,同时仍然优先考虑安全。

报告还指出了 OpenAI、谷歌和 Microsoft 等公司的人工智能团队经常面临的外部压力,称该公司的 ” 单一关注点 ” 使其能够避免 ” 管理开销或产品周期的干扰 “。

SSI 的目标是 ” 一步到位 ” 地创造一个安全的超级智能,专注于开发安全的超级智能——一种可以取代人类认知能力的机器智能。

SSI 的商业模式意味着安全、保障和进步都不受短期商业压力的影响。公司将不会因管理开销或产品周期而分心,致力于实现其唯一的目标——安全的超级智能。

苏茨克维表示,SSI 将是一个纯粹的研究机构,直接创造一个安全、强大的人工智能系统,同时不会在短期内推出任何商业化产品或服务。他强调,SSI 的安全性是指像核安全一样的安全,而不是简单的 ” 信任与安全 “。

尽管 SSI 的详细计划和资金来源尚未公开,但苏茨克维和他的团队已经明确了他们的愿景和目标。他们希望通过集中精力和资源,构建一个真正安全、能够为人类带来积极影响的超级智能系统。

回归 OpenAI 的初心

苏茨克维在 OpenAI 的早期领导地位中发挥了重要作用,特别是在生成式人工智能领域。

然而,去年 11 月,他与其他董事会成员迫使首席执行官萨姆 · 奥特曼(Sam Altman)下台,原因是对公司未来的发展方向和安全问题存在分歧。尽管后来奥特曼重新担任首席执行官,苏茨克维实际上从董事会辞职,并在 5 月离开了 OpenAI。

OpenAI 在 2015 年成立时与 SSI 有着相似的使命,当时它是一个非营利性研究实验室,旨在创造造福人类的超级智能 AI。虽然 Altman 声称这仍然是 OpenAI 的指导原则,但在他的领导下,该公司已经变成了一家快速增长的企业。

但苏茨克维在离开 OpenAI 时表示,他对接下来的事情感到兴奋,并将分享细节。他相信,在奥特曼等人的带领下,OpenAI 将构建出安全又有益的通用人工智能(AGI)。

尽管如此,SSI 的成立显示了苏茨克维对 AI 安全问题的深刻关注,以及他希望以一种不受商业压力影响的方式推进 AI 技术的决心。

津公网安备12011002023007号

津公网安备12011002023007号