最近,信美相互人寿收到了很多业内询问,其中不乏一些大型险企——信美3.0能不能开放给合作伙伴之外的公司试用?这个应用是咋设计出来的?

信美3.0是信美人寿相互保险社(以下简称“信美”)在不久前正式发布的“大模型保险垂直应用3.0”——信美Chat-Trust3.0,这是业内首批落地的能够精确进行专业计算的大模型保险垂直应用。

为啥能得到这么多询问?因为确确实实能够提高效率。举个例子,如果投保人希望得到一份个性化的保险计划书,代理人自己进行计算、归类、制作这一份计划书所用的时间大概在一小时左右,如果使用信美3.0,输入投保人的信息和需求后,大概30秒就可以生成。

“保险与大模型存在底层逻辑的高度契合性,二者的发展都需要大量数据的支持,因此保险公司也应当抓住机遇,深度应用大模型技术,为保险公司的各个业务环节赋能。”阳光保险集团首席科学家杜新凯表示。

事实也是如此,多家保险公司已经围绕大模型进行了布局,大势如此,增效只是第一步。

目前主要用于辅助工作

自2022年底ChatGPT掀起AI大模型热潮后,目前中国人保、中国太保、中国平安、阳光保险、众安保险等众多保险公司均已围绕大模型进行了布局。

2023年,中国人保发布了“数智灵犀—人保大模型”,并推出两款人保专属问答领域大模型应用——“人保智友”和“聪明宝”,两款应用分别面向个人和企业客户,提供保险产品咨询、理赔申请、保单管理等方面的服务,旨在提高用户体验和企业的保险管理效率。

中国太保搭建了保险行业首个全栈信创私有化部署的650亿大模型平台,准备了105万条保险大模型训练数据,通过了“中国人身保险从业人员资格考试”等3项保险领域的专业资格考试。

中国首家互联网保险公司众安在线财产保险股份有限公司已基于阿里云通义大模型,在还款预提醒、客服、理赔、营销、代码辅助等多个场景全面升级。

不过,目前大模型在保险业内依然主要用于辅助工作。这点可以从信美大模型的更新迭代中窥见一斑。

信美大模型保险垂直应用经历了三次版本更新。简单来说,1.0阶段类似内部助手,能够以知识问答的形式,回答一些关于公司的规章制度等。

2.0阶段则是类似专业化的数字分身,除了内部固定的知识问答之外,还提升了专业问题的先验认知,具备回复专业意见的能力。

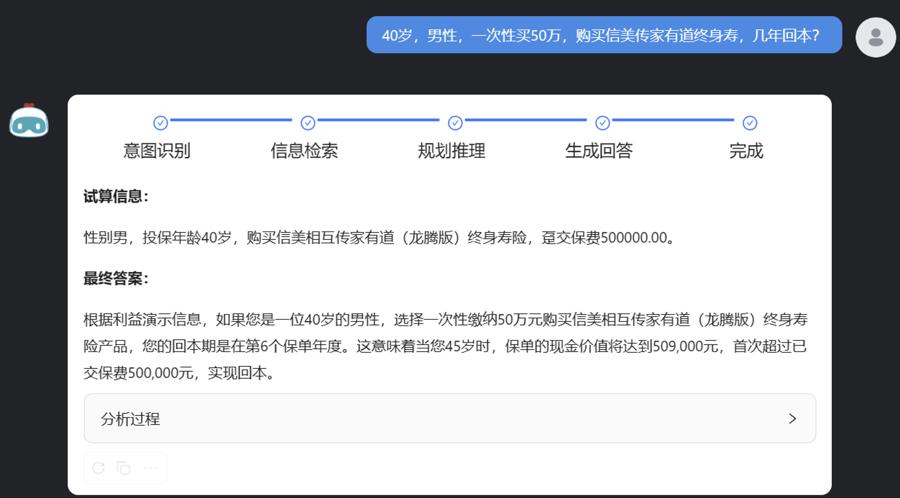

3.0阶段开始面向外部,一个独特之处是加入了计算能力且可以进行“白盒化”推演过程的展示。也就是说,除了回答一些文本类关于条款的专业知识以外,还能够提供部分产品的组合方案、收益率、保费等需要经过计算的问题。举个例子,当输入“40岁,男性,一次性买50万,购买信美传家有道终身寿,几年回本”的问题,可以得到“回本期在第6个保单年度”的具体回答。

信美3.0的演示界面。

信美3.0的演示界面。

“1.0、2.0都是面向内部,从内部获得反馈,3.0是首次对外开放,开始从市场获得反馈。”信美相互人寿董事长杨帆表示,这三次迭代想要实现的是从信息到知识的转变。大模型应用的迭代路径在所有行业都一样,信息来到专业领域就变成了知识,想要向外部解释知识,内部专业信息的整合是必须打下的地基。“大模型应用是永续成长的过程,越往C端走,要求就越高。”

增效只是第一步

为啥险企争相探索大模型的落地和应用?大势所趋不能落后是一方面,另一方面,大模型确实能够带来效率提升。

2023年底,由中国太保旗下的太保科技公司支持研发的“审计数字劳动力”在中国太保审计中心正式上线。据介绍,自上线运行以来,“审计数字劳动力”已代替审计人员自动执行审计任务近3万件,核查分析数据约25万条,节约人力约33人月,促进提升整体生产力约35%,实现人工智能技术在传统领域的融入。

让大模型释放员工的时间和工作量,去做更多更创新更有价值的事情,这一点已经成为业内共识。增效只是第一步,如果看向更远的未来,大模型也许会影响整个产品生态。

产品设计方面,业内人士指出,现在能够看到的保险产品的更新,通常是基于老产品的迭代,或者市场上同类产品的对比更新。未来能够通过大模型自身的数据收集和分析功能,更好地发现一些潜在需求,从而为产品更新迭代提供一些决策依据。

把控风险方面,对于险企而言,产品的定价依据大数法则,如果新产品无法尽快找到足够多的对应客户,风险也就无法分散,价格会被推高,最终导致产品没有市场而下线。借助大模型,则能够让险企更快识别出成规模、有共性的需求,再设计出相应产品,从而保证风险的可控。

可能性不止于此。目前,保险产品的信息不对称依然存在,一个重要原因是保险产品相对复杂,可能同时具有金融、医疗等多方面专业知识,理解起来门槛比较高。当AI可以帮助投保人低门槛理解知识,甚至协助直接判断信息时,那么产品供给就会形成良币驱逐劣币,会倒逼险企注重产品的性价比和与客户需求的匹配度。

当然,就眼下而言,AI技术仍存在幻觉、数据安全等问题无法忽视,应用在金融行业还面临着合规性、准确性和安全性等挑战,离全面重塑行业尚有距离。不过,这些美好想象正是各家险企争相试水大模型应用的原因。

津公网安备12011002023007号

津公网安备12011002023007号