今年的苹果 WWDC,是一场事先张扬的 AI 发布会,库克罕见地从几个月前就在各种场合渲染气氛。

可当你上个月看过 OpenAI 和 Google 、微软的发布会,又会觉得这不像一场 AI 发布会。

苹果甚至没有正式发布一款大模型,没有对比友商参数量、多模态能力这些常规环节,没谈 AGI 的未来,也没有祭出像 Copilot 这种被媒体高呼「颠覆一切」的爆款应用。

苹果反而造了一个叫 Apple Intelligence(下称「Apple 智能」)的词,这个谐音梗是在告诉人们,苹果发布的不是一款软件或硬件,而是一种新的用户体验。

库克认为 AI 必须以用户为中心,需要无缝集成到你日常使用的体验中:

它必须了解你,并基于你的个人背景,比如你的日常生活、你的人际关系、你的沟通等等,所有这一切都超出了人工智能的范围。这是个人智能,也是苹果公司的下一个重大举措。

苹果选择将 AI 能力渗透到整个生态之中,这意味着很难看到 GPT-4o 那种让人欢呼的演示,但这种「没有惊喜」和去年 iPhone 15 发布时有所不同,那是智能手机宏大叙事终结的侧写。

而 Apple 智能,是在给 AI 应用铺垫一种新的叙事,这可能不只是苹果的新篇章。

个人智能和个人隐私

在 Apple 智能亮相时,苹果就总结了它的五个特点:强大、易用、深度整合、个人化、私人化。

要想让 AI 融合生活细节,甚至不被察觉,得让 AI 甚至比你还了解你自己。这也意味着你的个人数据越多,就越可能实现,随后不能不面对的问题就是:这是否要建立在让渡个人隐私的基础上实现?

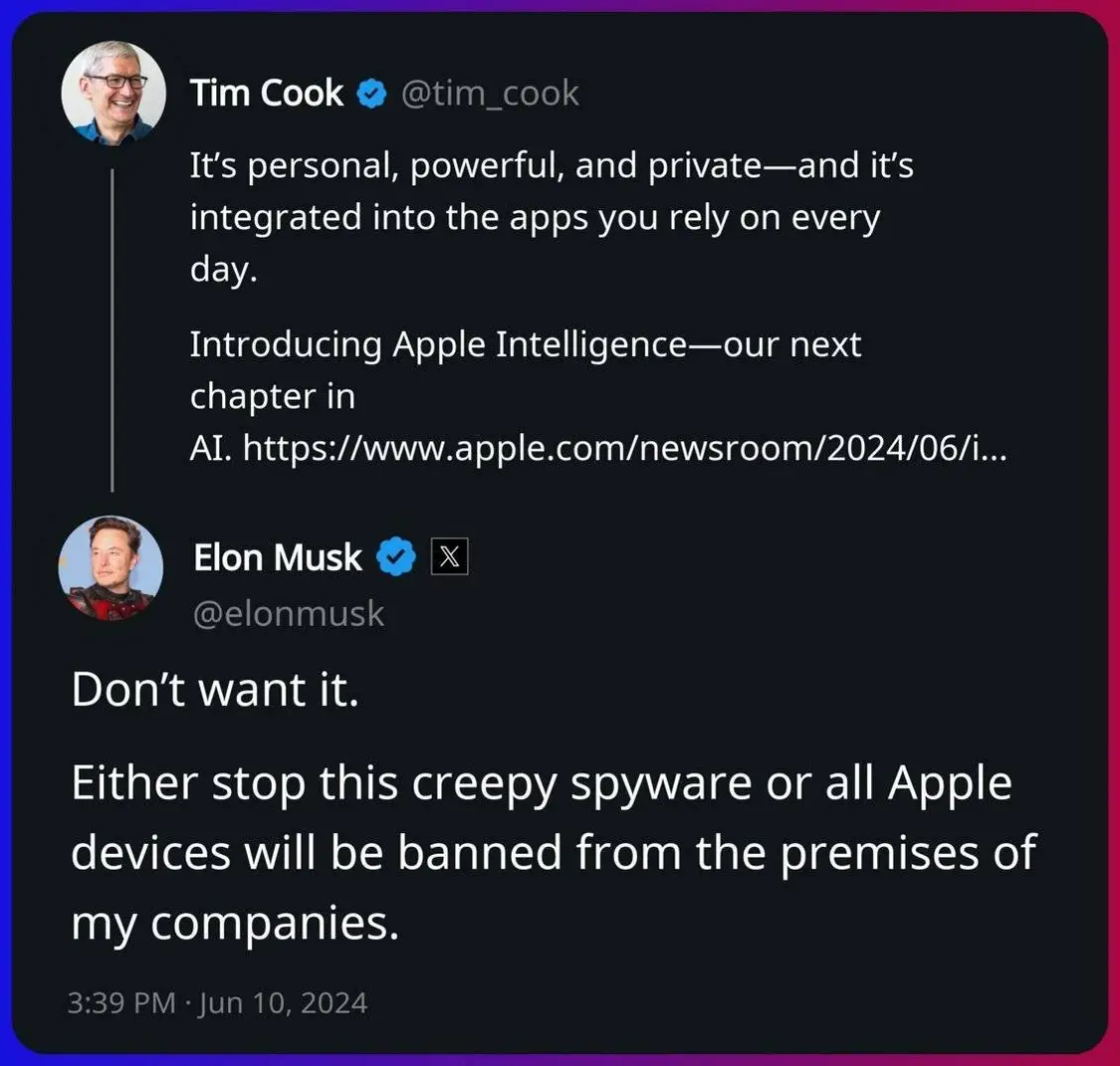

这也是发布会后,马斯克批评苹果的由来。

他甚至直接在库克的推文下表示「要禁止所有苹果设备进入我公司的办公场所」,并对苹果和 OpenAI 合作后用户隐私安全的保护提出质疑。

其实这也的确是用户会担忧的问题,尤其对于活跃设备高达 22 亿的苹果。但这也和苹果对隐私保护一向慎重的行事风格相悖。

过去苹果设备和 AI 相关的功能基本都是依靠本地机器学习实现的,所需的数据量很少,很大程度上就是基于对个人隐私的考虑。

虽然苹果在发布会上对这些问题没有一一介绍,但我们通过会后的一些媒体分享会,也了解到更多 Apple 智能在隐私方面的处理方式,可以试着厘清目前网络上争议较大的一些问题。

APPSO 获悉,苹果针对涉及云端的数据处理提供了两个新的解决方案。

首先,用户不必将所有数据、所有邮件、所有消息、所有照片、所有文档发送到别人的云端并存储在那里,以便服务器模型在需要时可以探测它们。

相反,用户的设备上的 Apple 智能会找出哪些小部分信息与回答这个问题相关。因此,向云端提出的问题只包含这些小部分信息,而苹果对小部分信息再进行保密处理。

苹果创建了一个加密系统,比如 iPhone 只能与带有指定标签的服务器通信。换句话说,如果这台服务器上的软件有任何更改,其签名也会随之改变,而你可以拒绝与其通信。

包括和 OpenAI 合作的用户数据处理也是,拥有注册账号的用户 IP 地址在使用服务时会被隐藏掉,OpenAI 也不被允许记录用户请求。

这或许会在一定程度解答公众的疑惑,苹果也的确有必要在这方面披露更多信息。强调「个人化」的 Apple 智能,要实现发布会上的蓝图,这是必须要处理好的问题。

而且苹果和 OpenAI 的合作模式很可能并非独家,未来在不同的场景,不同的地区,显然是保留了其他大模型合作的空间。

这也并非苹果一家厂商要面临的问题,但无论是谁都必须慎重挑选合作伙伴,当 AI 随着大量终端设备渗透生活,隐私和便利的交锋会愈加激烈,即便被认为是忍受度更高的中国市场亦是如此。

一场没有硬件的发布会,却对硬件影响很大

Apple 智能从命名到实现方式,都看出苹果要以自己的方式来定义 AI 硬件,将 AI 能力渗透到整个生态之中,而不是推出某一个杀手级应用和功能。

这是和目前大量 AI 硬件最大的不同,去年开始硬件厂商掀起了 AI 硬件的潮流。当中不少都是将 AI 硬件简单等同于大模型+终端设备,结果就是推出的往往是某个功能,更新实验性质的半成品。

这也是 Ai Pin 和 Rabbit R1 等网红 AI 硬件热闹一波就折戟沉沙的重要原因。

Apple 智能的思路和过去机器学习在苹果产品的应用方式类似,尽管苹果不怎么提 AI ,但已经融入到很多常用的小功能,比如 AirPods Pro 自适应音频模式也是通过机器学习实现。

很多人说在大模型时代苹果已经掉队,从单一技术上来说很可能的确如此,但苹果需要的从来不是一个比 ChatGPT 更牛逼的模型,而是将算力转化为整体而非局部的体验。

虽然这场发布会系统和软件是主角,但硬件是没有被明示但却至关重要的一环。APPSO 了解到,这次 Apple 智能在端侧运行的是规模在 30 亿参数的模型。

苹果对此低调但却充满信心,据悉苹果工程师认为这是目前最好的端侧模型。

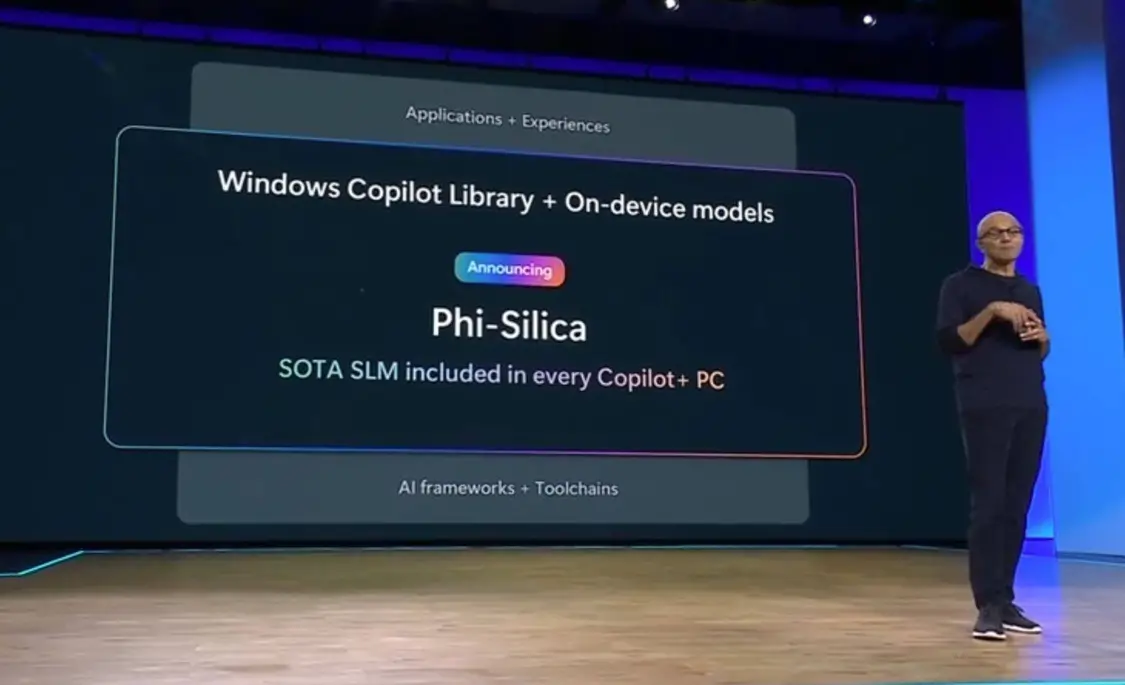

作为对比,不久前微软发布的端侧小模型 Phi-Silica 参数为 33 亿,而国内手机厂商在端侧大部分场景的模型大约在 70 亿-130 亿参数之间。

参数越高大概率意味着更高的性能,但如果能以更小的参数规模实现同样的性能,这对移动设备和大模型的结合有更大的意义。

而且业内很多研究已经证明,经过微调的小模型性能在某些使用场景下未必不如大模型。苹果此前曝光的开源小模型 OpenELM ,就涵盖 2.7 亿、4.5 亿、11 亿和 30 亿参数。

尽管苹果认为用户看重的是体验,并非参数规模,但端侧模型大概率是苹果在悄悄发力的地方。

如果顺利,苹果极有可能推动一波新的硬件浪潮,从 Vision Pro 到带摄像头的 AirPods,以及传言中的家务机器人等。凭借强大的设计生产和供应链能力,苹果可以重新用软件来塑造硬件。

这场没有发布任何新硬件的发布会,可能才是近年来对苹果硬件影响最大的一次发布会。

Siri 将成为苹果真正的操作系统

当苹果要将 AI 的能力集成到操作系统中,Siri 就成为重要的桥梁。

在媒体分享会上,苹果公司机器学习和人工智能战略高级副总裁 John Giannandrea 就表示:

Siri 不再仅仅是一个语音助手,它实际上成为了一种设备系统。

我们之前在 WWDC 前瞻文章也预测过,苹果 AI 最终的目标是实现这样的场景:早上起床,用一句「Siri」唤醒 Siri,再让它打开微信公众号「爱范儿」,朗读最新的文章,就这样在完全不用动手的情况下,听取爱范儿的早报。

Siri 能变聪明,其实就是语义理解能力的提升,能像人一样理解所有这些数据的含义。随着时间的推移,这种理解会变得更加丰富。

大模型兴起后的自然交互语言,一直被认为将取代我们现在和设备的图形界面 GUI,背后是计算机对自然语言的理解能力大幅提升。

基于自然语言的交互到来,影响的不只是我们的随身设备,应用的形态也将完全改变,比如 Siri 通过 API 调用具体的能力执行各种任务,甚至 app 都将不需要了,或以一种新的形态出现。

OpenAI 已经离职的联合创始人 Andrej Karpathy 也表达了类似的观点,他认为这是 Apple 最令人兴奋的地方,并列举了六点理由:

多模态 I/O:支持文本、音频、图像和视频的读写功能。这些可以说是人类的原生 API。

代理性:允许操作系统和应用程序的所有部分通过「函数调用」进行互操作;内核进程的 LLM 可以根据用户查询调度和协调工作。

无缝体验:以高度无缝、快速、始终在线的方式完全集成这些功能。无需复制粘贴信息或提示工程,相应地调整 UI。

主动性:不仅是根据提示执行任务,而是预测提示、提供建议并主动执行。

委派层级:尽可能多地在设备上运行智能(Apple Silicon 非常适用),但也允许将工作委派到云端。

模块化:允许操作系统访问和支持整个不断增长的 LLM 生态系统(例如 ChatGPT 的发布)。

隐私保护:<3

苹果 WWDC 各种细节,都在隐隐指向这个未来。但苹果也知道这大概率还不会在几年内实现,所以只告诉你,起码 Siri 好用多了。

过去两年,我们最不缺的,其实就是 AIGC 带的「Amazing」。但犹如手机和互联网那般,深度嵌入生活肌理的技术或产品,还不见端倪。

润物细无声,才是技术革新的终极目标,也是 AI 的理想形态,这也是 Apple 智能最值得期待的地方。

津公网安备12011002023007号

津公网安备12011002023007号