首个打通从多模态输入到多模态输出的「全能高手」,统一多模态预训练模型 Emu 开源,来自智源研究院「悟道·视界」研究团队。

超越了此前 DeepMind 的多模态大模型 Flamingo,Emu 刷新8项性能指标;并且模型能力覆盖图像与文本的生成及视频理解,更通用,能完成任意图生文以及文生图的多模态任务。

这一突破来自于 Emu 创造性地建立了多模态统一学习框架与视频数据的大量采用,最终得以实现对任意形式的多模态的上下文序列进行图文任意模态的补全,即对于任意模态进行下一步自回归预测。

Emu 在众多常用测试基准上表现出极强的零样本性能,展现了模型在遇到未知任务时强大的泛化能力。其中,Emu 在图像描述 COCO Caption 的 CIDEr 得分为112.4,且模型对图片的描述中包含丰富的世界知识。此外,Emu在图像问答 VQAv2 和视频问答 MSRVTT 数据集上也展现了强劲的视觉问答功能。

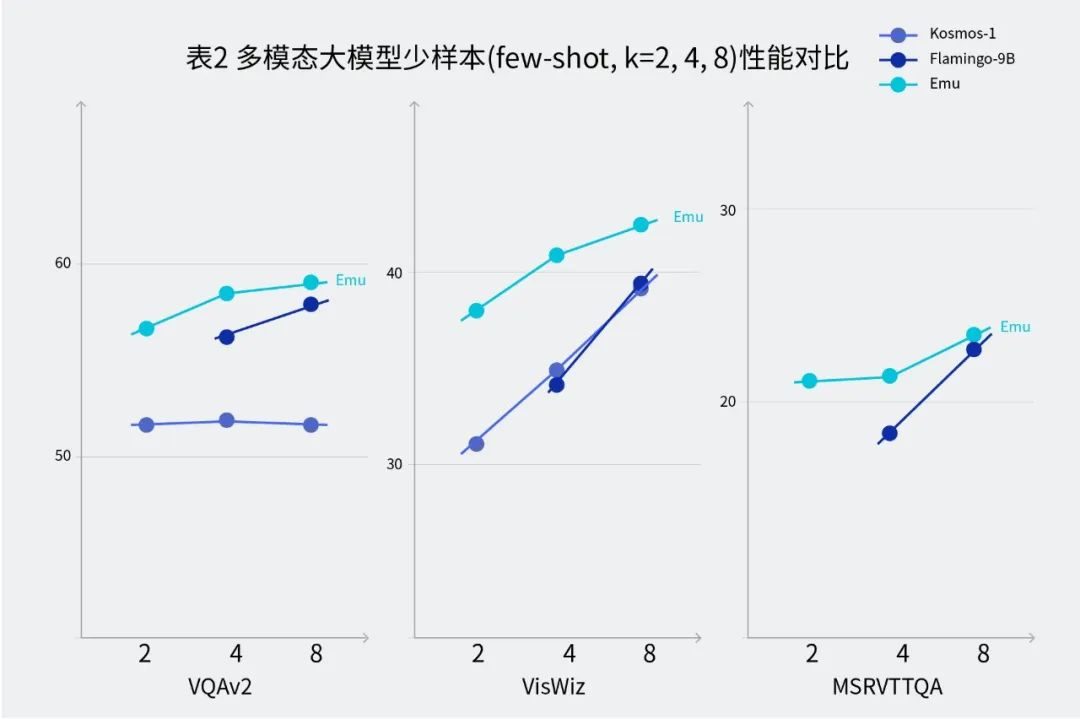

同时,Emu具备强大的少样本上下文学习能力,即对于给定任务提供几个示例样本,模型可以进行上下文学习从而更好地完成任务。Emu在视觉问答数据集 VQAv2、VizWiz、MSRVTTQA上的少样本上下文学习表现突出。

表2 在few-shot (k = 2,4,8)推理设置下,Emu在图像问答和视频问答任务中的表现

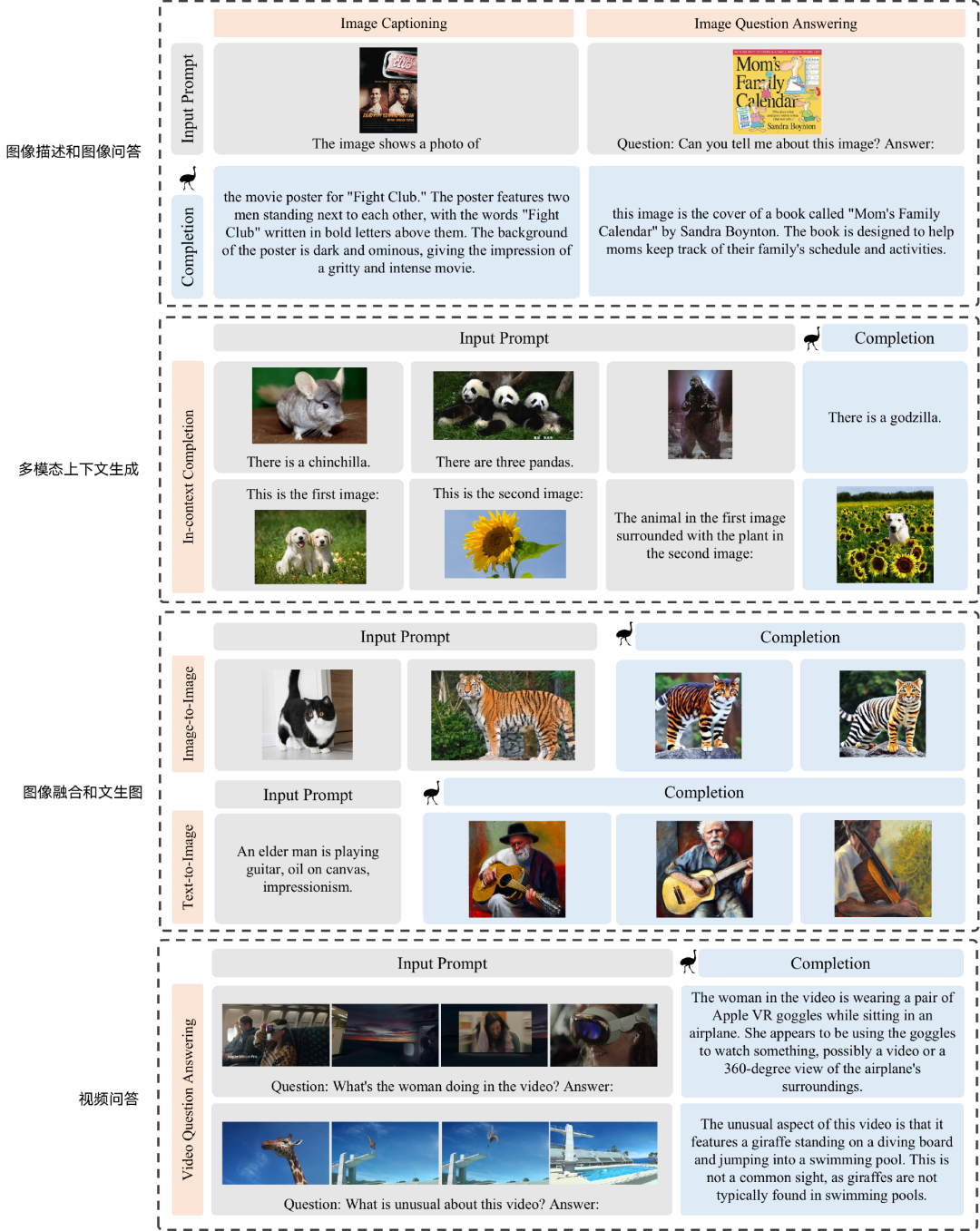

全能高手:在多模态序列中进行「图文任意模态生成」

视频理解、多模态上下文生成、多模态对话是 Emu 模型的技术亮点。

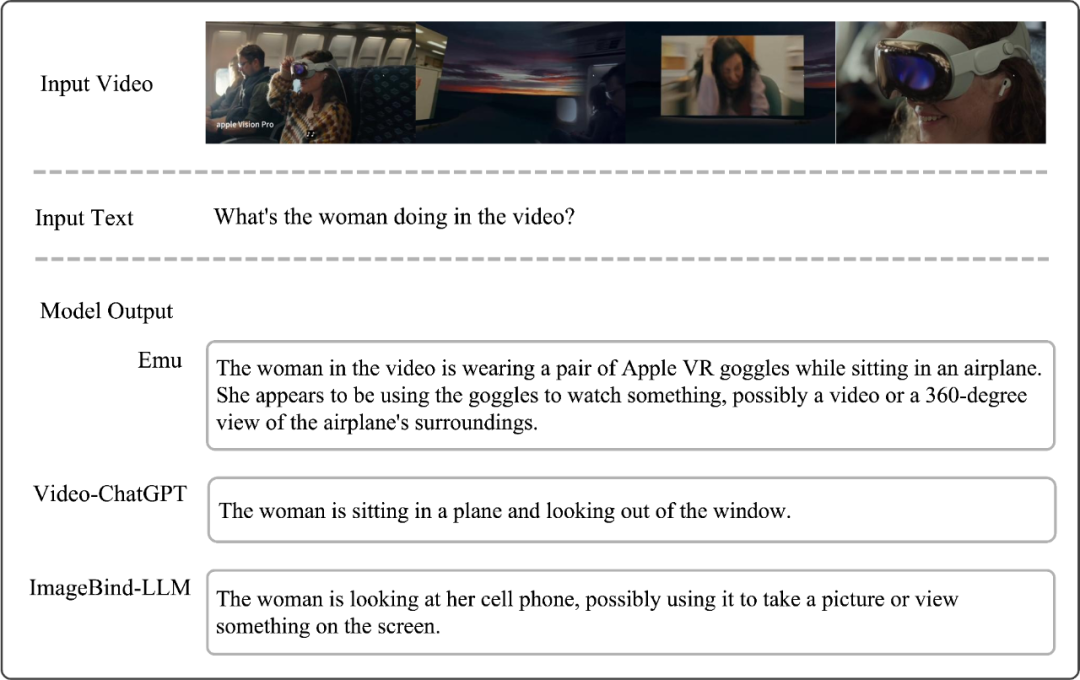

Emu 模型具有强大的视频理解能力,如在下图演示中,针对下面“视频中的女主人公在干什么”这一问题,Emu 模型给出了具有精准事实细节(苹果VR设备)、连贯动作描述(坐在飞机上并使用VR设备)、合理行动猜测(可能在看一段视频或360度视角的飞机外景象)的丰富回答。

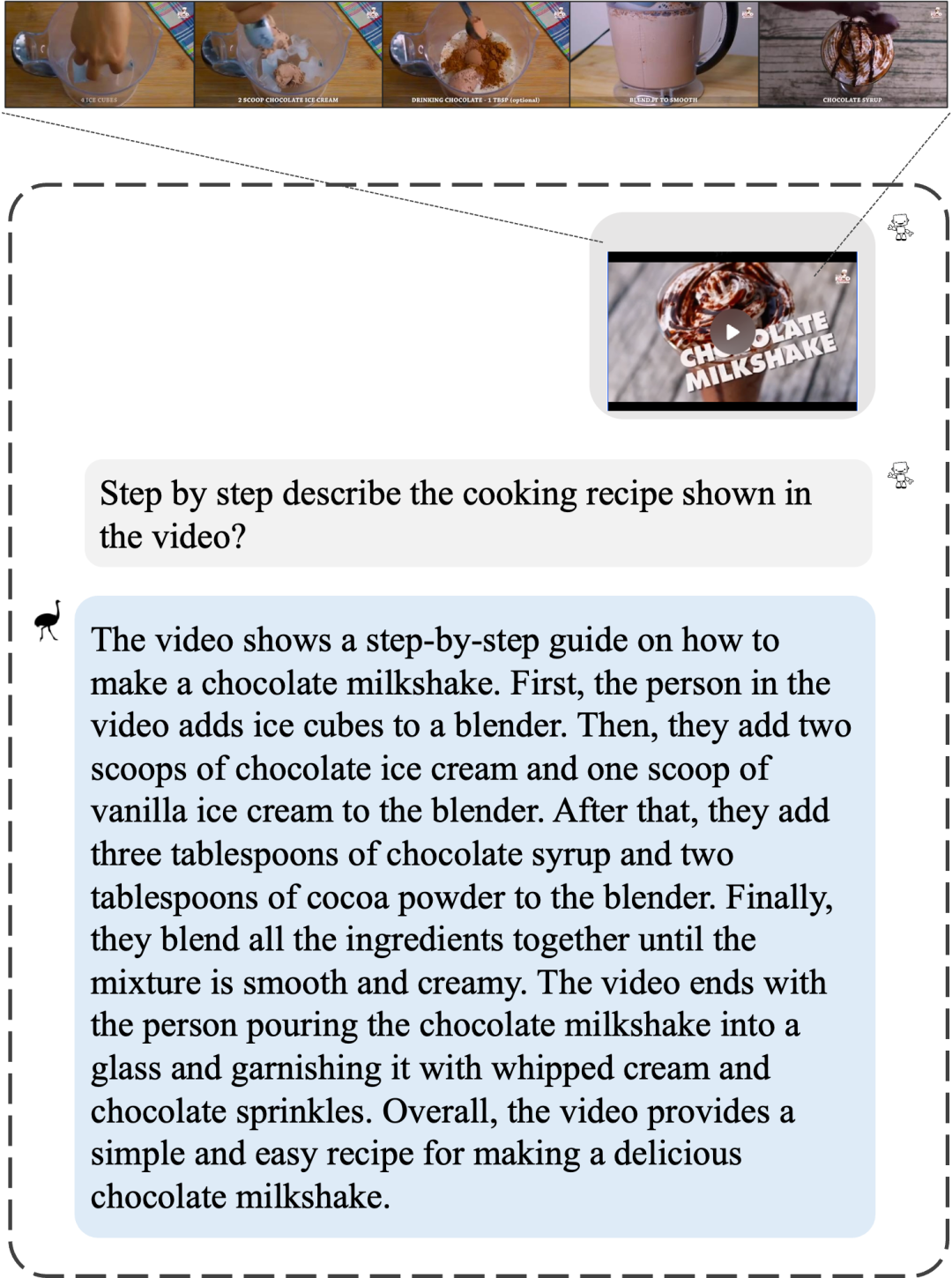

Emu 不只能理解视频信息,还能做到对视频中时序信息的精细理解。例如下图展示的奶昔制作视频,Emu 分步且完整地描述了奶昔制作步骤。

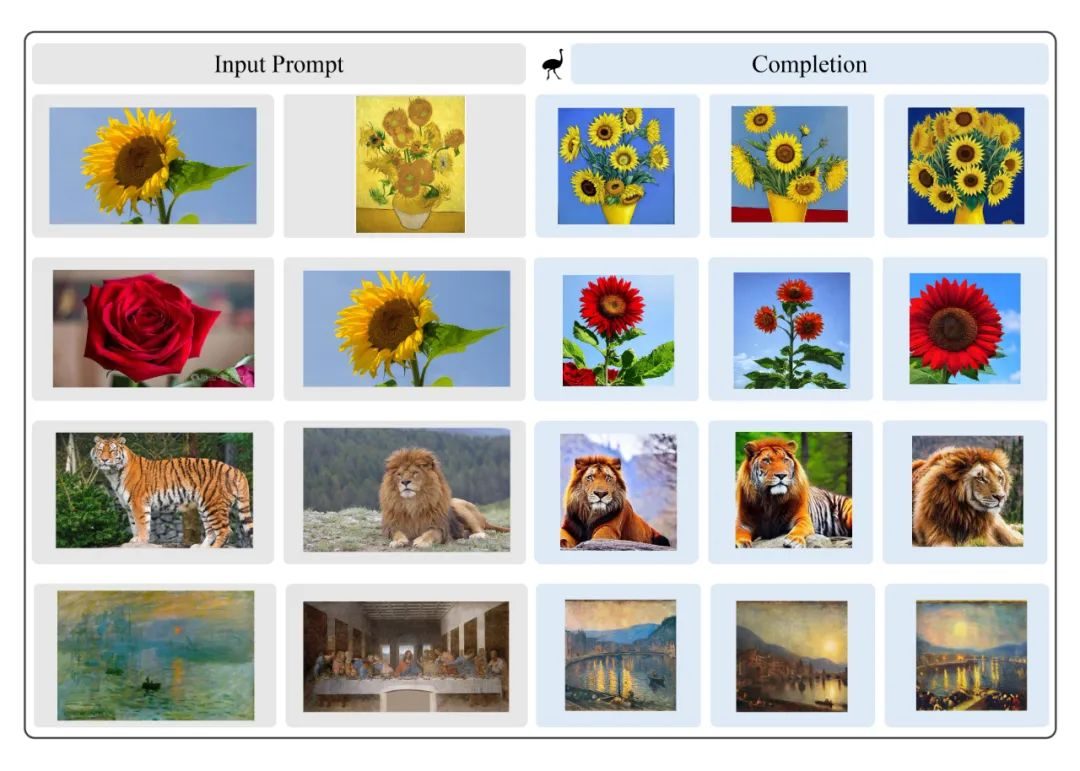

Emu 新增了图像融合能力,可以对输入的图像进行创造性地融合,并生成新的图片。例如下图最后一行,将两幅世界名画作为输入,Emu 可以生成风格、元素类似的全新画作:

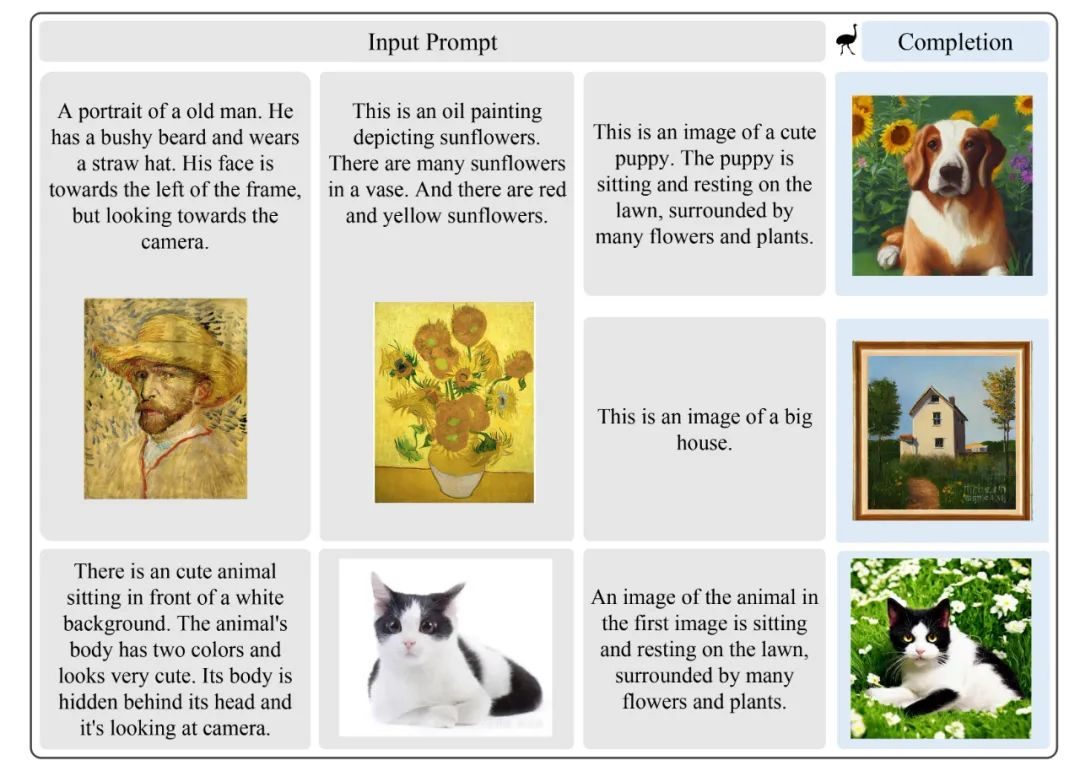

上下文图像生成也是一项全新的功能,Emu 可以将输入的文本-图片对作为 prompt,结合上下文信息进行图片生成。例如,如果输入图1、图2两张图片,并输入文本指令让Emu 生成以图1的动物为中心,但以图2为风格的图片。依赖于强大的多模态上下文生成能力,Emu可以完成相应的指令。下图的第一行展示了如果在“文生图”时提供了context,Emu 会结合context 的风格,生成油画风格的图片,而相同的文本在无context 的情况下进行“文生图”只会生成现实风格的图片:

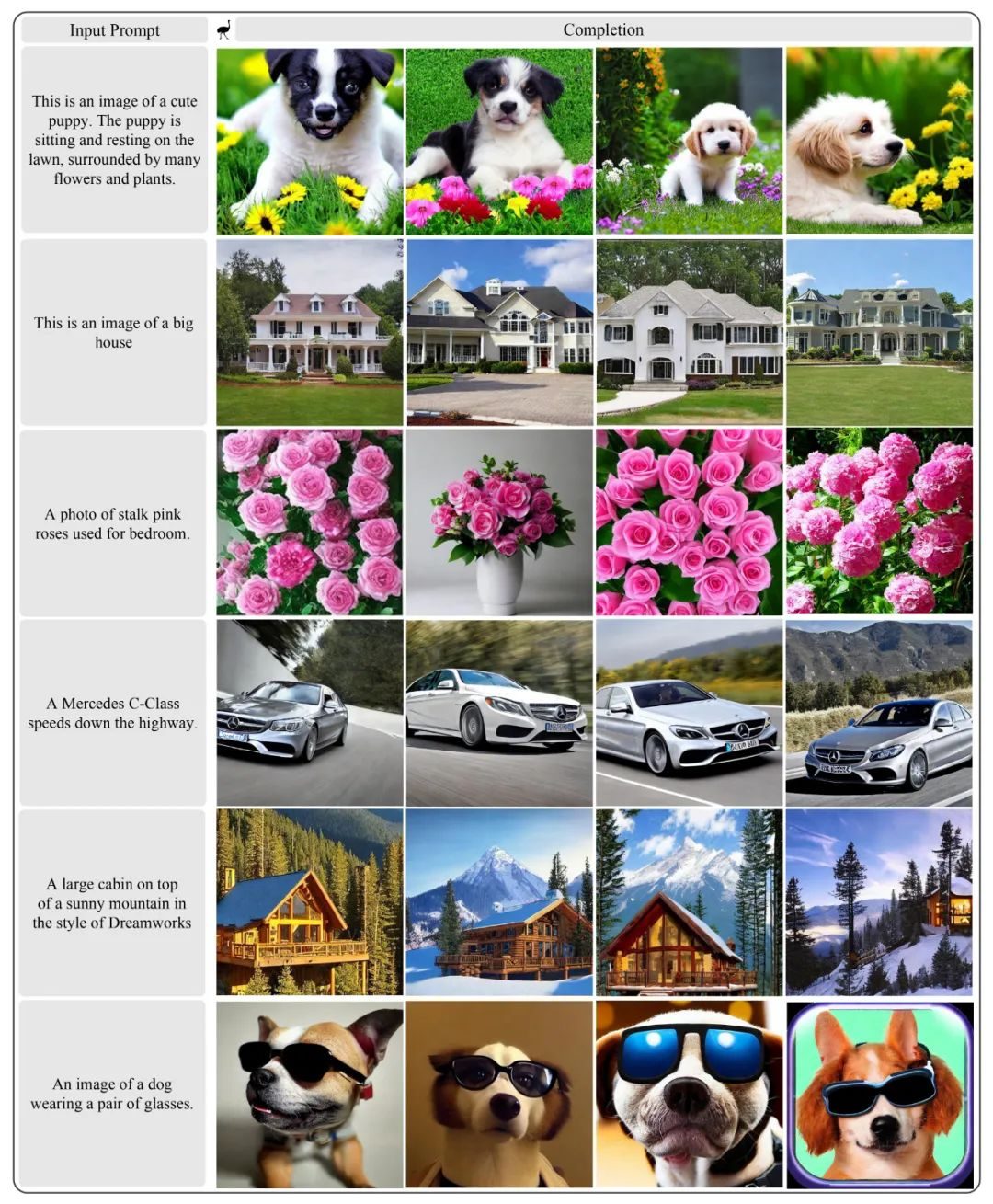

图像生成方面,Emu 可以根据给定的文本生成多幅语义相关的图像:

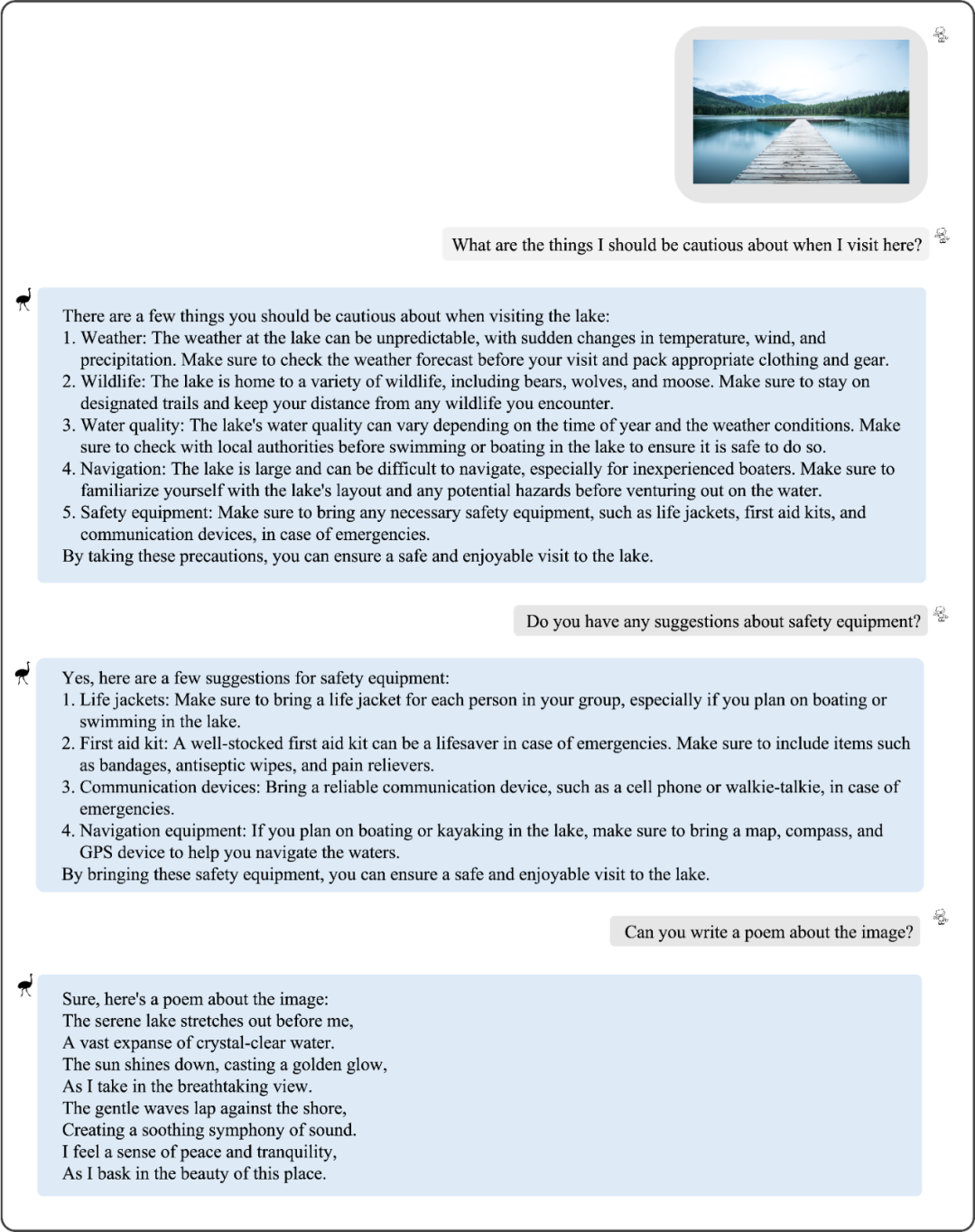

Emu 可根据一张或者多张图或视频进行问答和多轮对话。如下第一张图所示,给出一张景点图并询问旅游注意事项,Emu 给出了5个要点,其中再就第5个要点 “ safety equipment”提问时,Emu 能够针对这一点进行更加详细地阐述。最后,Emu 还可以根据图片作诗。

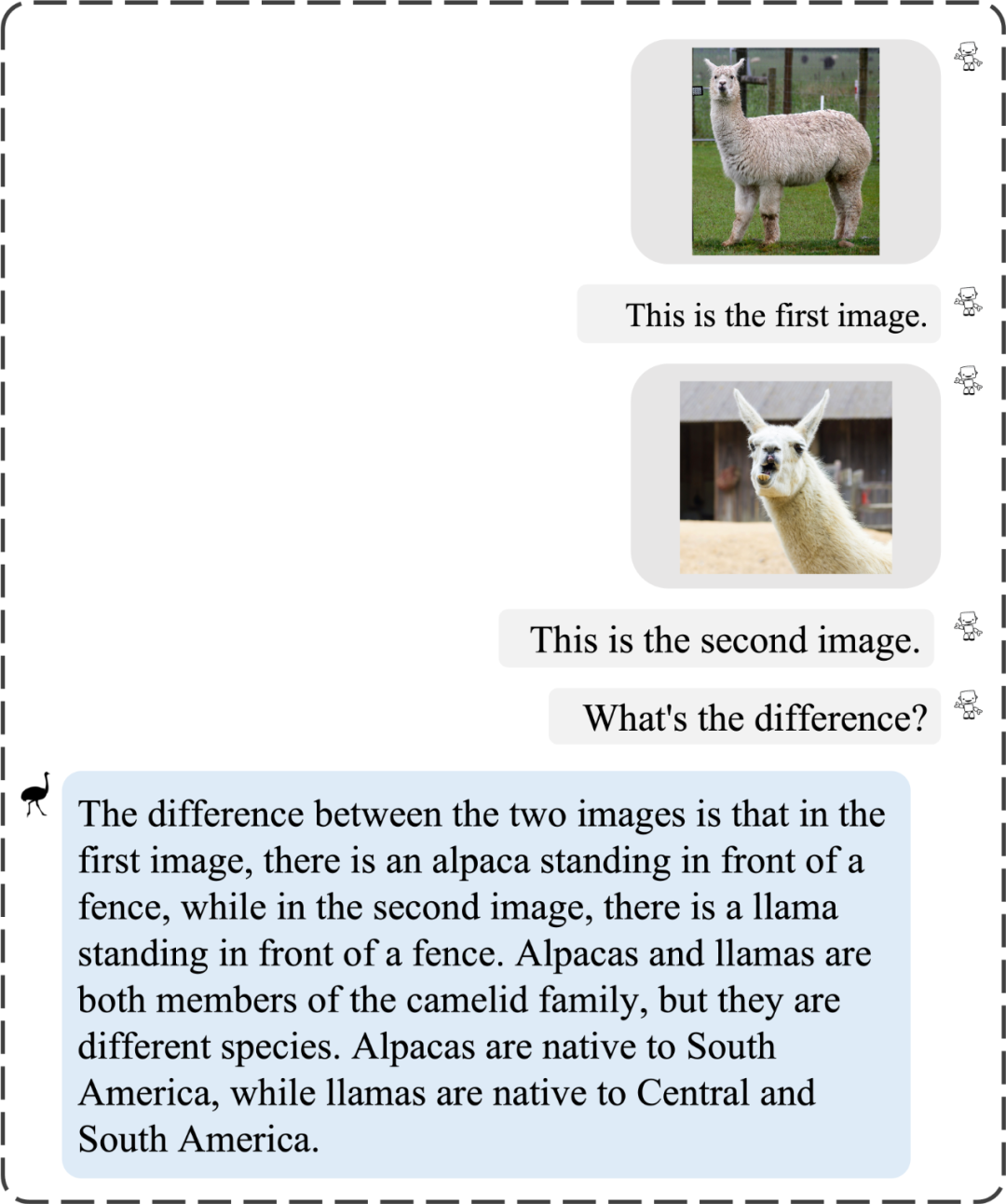

Emu 还有一项突出的能力是它的世界知识更丰富。如下图所示,给出两张动物的图,询问这两张图的区别,Emu 可以准确描述动物的名称及分布地:

Emu 模型可以准确识别画作,例如下图输入莫奈的《日出·印象》这幅作品, Emu 不仅准确回答出了作品的名字,描述了画面信息,还给出了很多背景知识,例如这是著名印象派风格的作品。而 mPLUG-Owl 、LLaVA 并不知道画作的名称,只是简单描述了画中场景。InstructBLIP 给出了作品名称和描述,但在背景知识上略逊于 Emu。

津公网安备12011002023007号

津公网安备12011002023007号