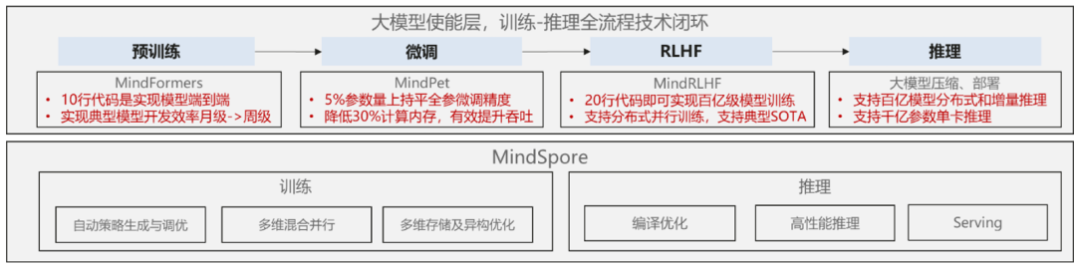

在最新2.0版本,我们支持多维混合自动并行能力,提供大模型套件支持一站式训练,打造大模型最佳训推平台。在提升易用性方面,提供了大量开箱即用的模型套件,且支持灵活高效的动静统一,同时打造AI+科学计算领域套件,突破前沿特性,助力行业技术创新等,下面就带大家详细了解下2.0版本的关键特性。

昇思MindSpore 2.0版本提供一站式大模型训练、推理一体化能力,提升训推性能及可跑模型规模,提供套件降低训练成本。

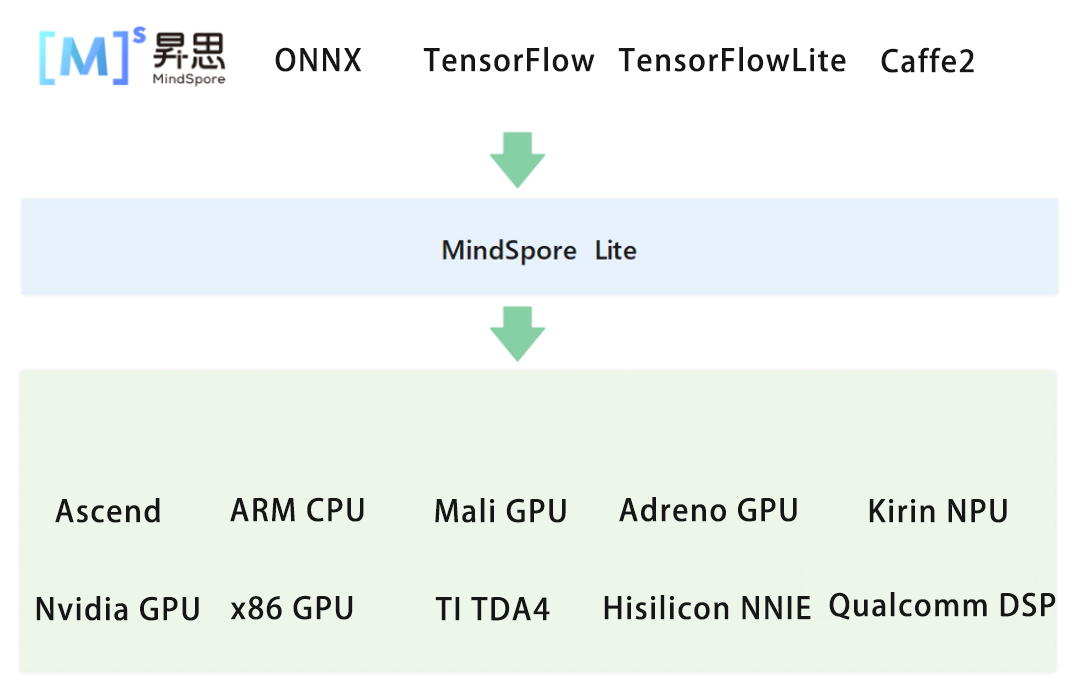

(2)MindIR原生支持:MindSpore训练后模型直接使用MindIR无缝推理,缩短模型上线周期;

(3)模型格式统一:支持三方生态(TF、ONNX、Caffe)导出MindIR,实现推理格式归一,减少线上维护工作量;

(4)优化策略多样化:支持算子融合、常量折叠、格式转换、冗余算子消除等推理优化策略以及支持AVX512等高级指令优化算子,提升模型推理性能;

(5)大模型极致优化:针对主流的Transformer大型网络进行深度融合优化,减少模型内存占用,大幅提升推理性能。

MindSpore Lite参考文档:

https://mindspore.cn/lite/docs/zh-CN/r2.0/index.html

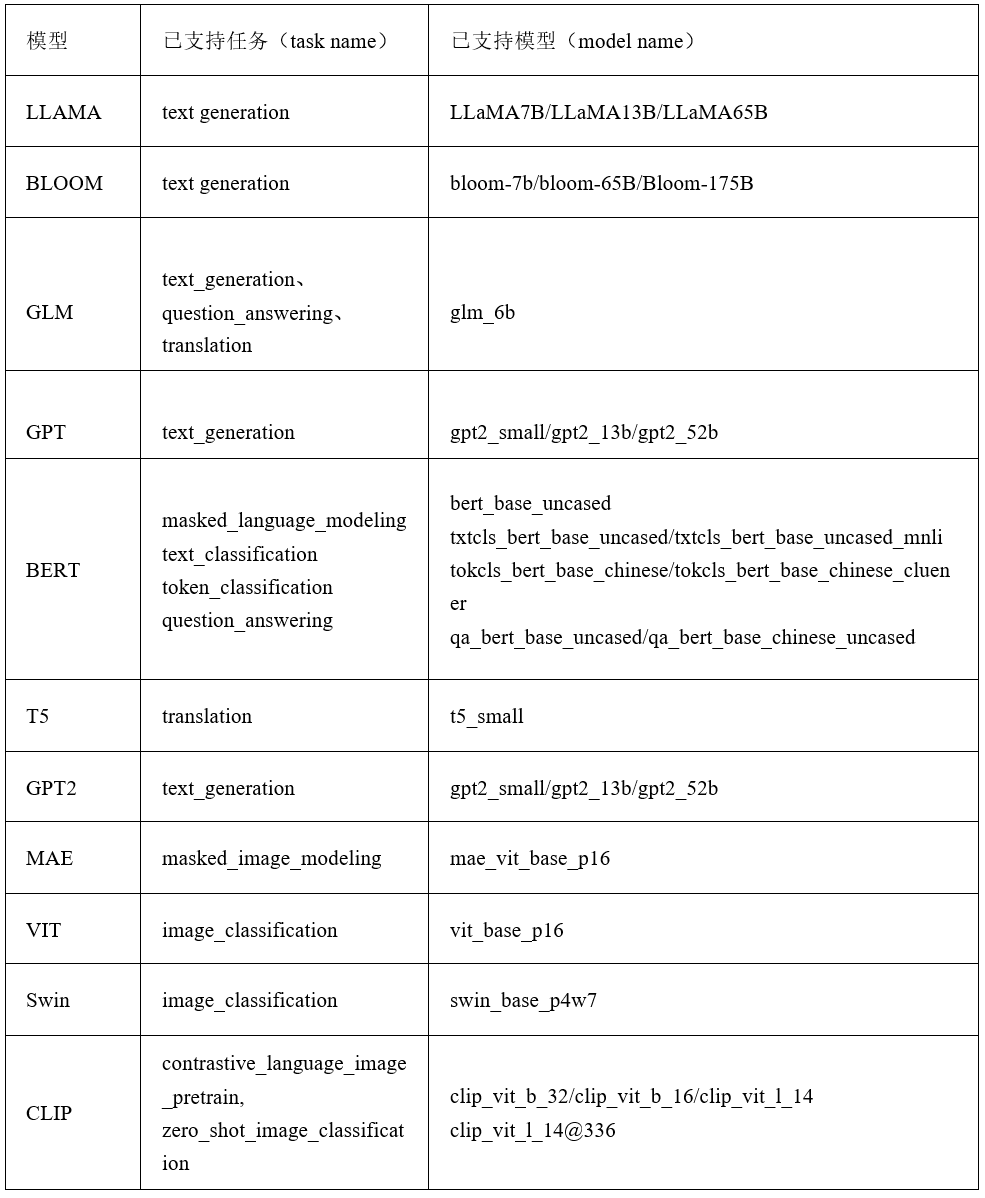

(1)基于Trainer接口实现2行代码训练,Pipeline接口实现3行代码推理,支持自动模型下载。

(2)提供GPT/GLM/BLOOM/LLAMA等热门领域的模型,支持丰富的下游微调任务,精度与SOTA基本持平,列表如下:

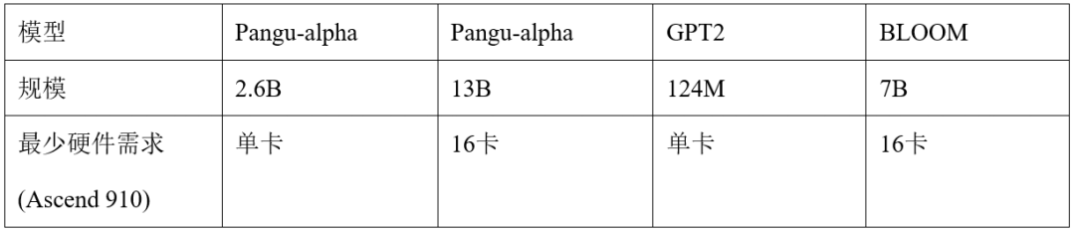

MindSpore RLHF包含算法所需的三个阶段的学习流程:预训练模型训练、奖励模型训练和强化学习训练。通过集成MindSpore Transformers中丰富的模型库,提供了Pangu-Alpha(2.6B, 13B)、GPT-2、LLAMA、BLOOM等基础模型的微调流程,同时完全继承MindSpore的并行接口,支持一键部署不同规模的大模型到训练集群上。

当前MindSpore RLHF支持的模型如下表所示:

MindSpore Transformers的目标是构建一个大模型生命周期内,训练、微调、评估、推理的全流程的开发套件,覆盖CV、NLP、AIGC等热门领域,提供快速开发能力,支持10+ SOTA预训练大模型开箱即用,可一键部署AICC上云。

表1 :当前MindSpore RLHF支持模型和规模

当前版本支持Pangu-alpha(13B)、GPT2、BLOOM模型进行RLHF训练。未来,我们将提供更多

津公网安备12011002023007号

津公网安备12011002023007号