这波AIGC(利用人工智能技术来生成内容)的热潮,已经开卷视频了。

上个月初,白话君说过,阿里达摩院正在研发类ChatGPT的对话机器人,当时已开放给公司内员工测试。

没想到,一个多月后,先露面的是文本生成视频。

就在昨天,阿里达摩院低调地在魔搭社区(ModelScope)放出了“文本生成视频大模型”。魔搭,是达摩院在去年11月推出的开源模型平台。

根据官方介绍,目前这个模型,由文本特征提取、文本特征到视频隐空间扩散模型、视频隐空间到视频视觉空间这3个子网络组成,整体模型参数约17亿。支持英文输入。扩散模型采用Unet3D结构,通过从纯高斯噪声视频中,迭代去噪的过程,实现视频生成的功能。

看不太懂?没关系。会玩就行。

白话君刚才试了一把。输入提示词:A panda eating bamboo on a rock,等了差不多77秒,收到一段2秒钟的视频。 感受一下~

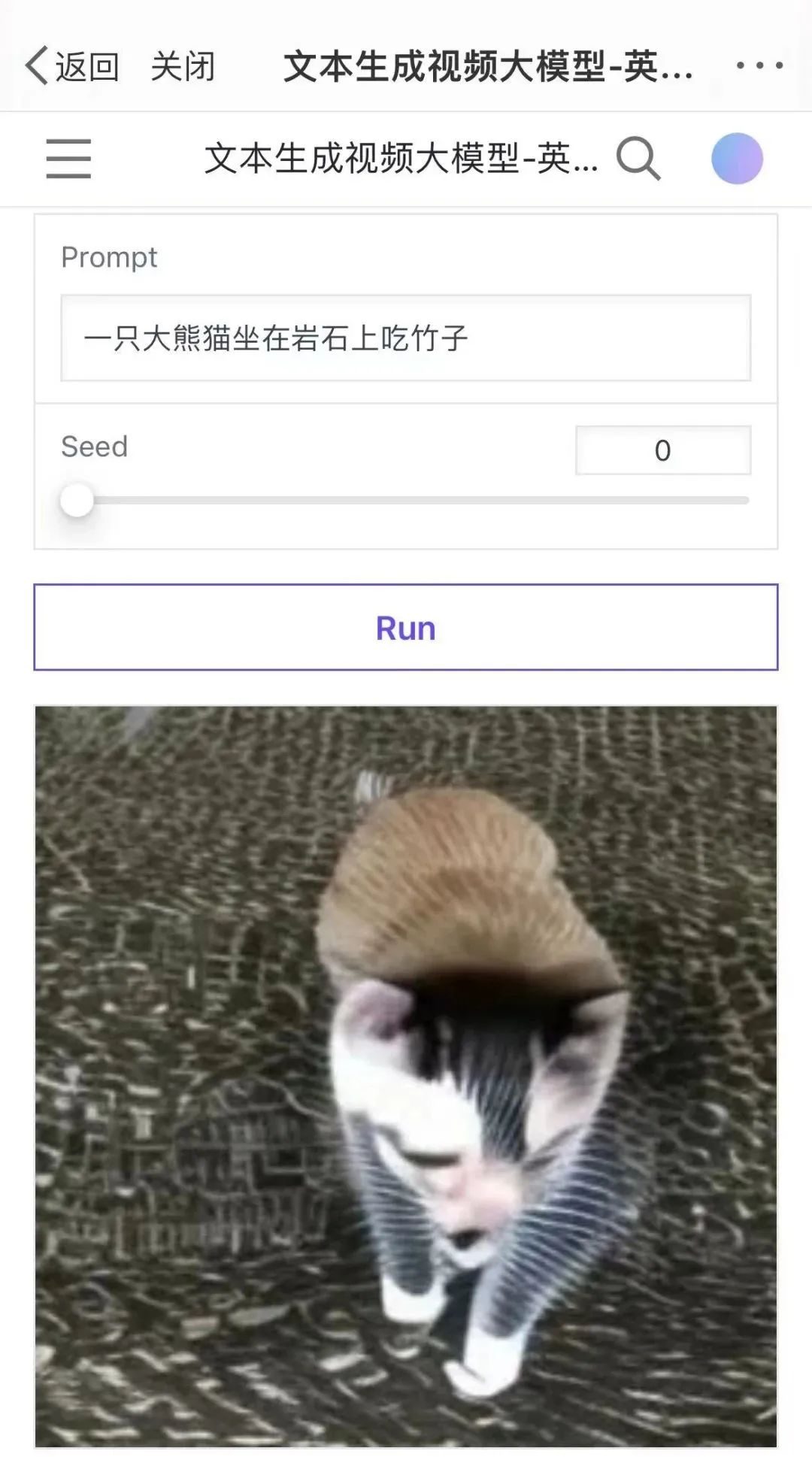

如果换成中文:一只大熊猫坐在岩石上吃竹子,出来的结果就是一只类似于猫咪的小动物。果然,目前还不支持中文。

再来几个~

A goldendoodle playing in a park by a lake.(一只金贵犬在湖边的公园玩耍)

A dog wearing a Superhero outfit with red cape flying through the sky.(一只身着超级英雄装和红斗篷的狗正在天上飞)

Monkey learning to play the piano.(猴子正在学习弹钢琴)

从试玩的结果来看,目前能生成的视频长度多在2-4秒,生成等候时间从20多秒到1分多钟不等。

感兴趣的,不妨自己去体验一下(试玩地址:https://modelscope.cn/studios/damo/text-to-video-synthesis/summary)

达摩院的这个发布,也在国内外的社交平台上吸引了一波尝鲜的网友。因为玩的人太多,有微博网友说,连刷20次都没挤进去。

另外,今天凌晨,总部位于纽约的人工智能初创公司Runway也发布了一种从文本到视频转化的AI模型Gen-2。

上个月,这家曾参与创建Stable Diffusion的公司推出过模型Gen-1,能通过文本提示或参考图像指定的风格,将现有视频转化为新视频。

比如将“街道上的人”变成“粘土木偶”,只需要一行提示词。![]()

从命名上就能看出,Gen-2是Gen-1的升级版,能从零开始产出视频。目前,我们只能看到Runway分享出来的一些演示片段。根据该公司的说法,未来几周会提供广泛访问试用。

津公网安备12011002023007号

津公网安备12011002023007号