今年10月,作为苹果公司与哥伦比亚大学的研究成果,Ferret就已经发布过一次,只是当时仅供研究使用而非商业许可,所以并未引起多大关注。如今情况发生了转变,随着各大科技公司你追我赶地公布研发成果,关于本地模型为小型设备提供智能体验的讨论也越来越多。

12月以来,苹果也陆续公布它在AI领域的研发进展。12月初苹果公布Apple Silicon平台专用AI框架MLX、以及能在设备端执行大语言模型的方法,后者能在边缘设备上执行DRAM两倍大的模型,可节省执行大模型所需的运算资源,也更能确保隐私安全。

上周,苹果再次公布全新成果——Ferret大语言模型以及相关标竿测试工具与数据集。

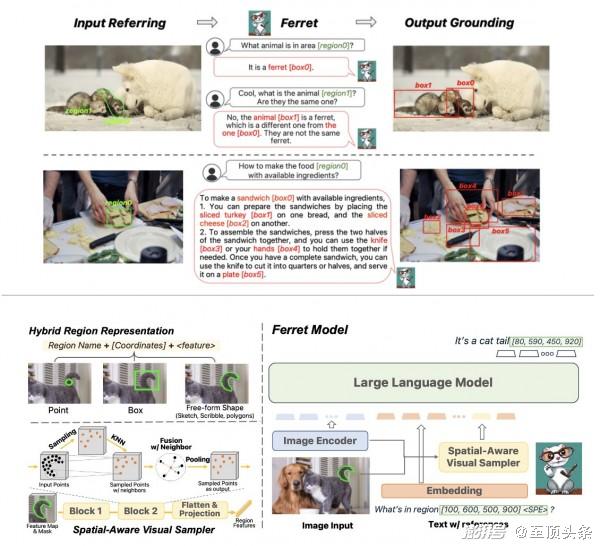

作为一款多模态模型,Ferret可以接受文字、声音、影像或数据的输入。根据苹果10月公布Ferret的研究论文,Ferret能理解任何形状或任何图片颗粒(granularity),并且可以准确定位(ground)开放词汇的描述。为了把引用(refer)和定位能力整合到模型中,Ferret采用一种混合区域表征(hybrid region representation)技术,整合个别方位和连续性的特征,以表示图片中的某一区域。为提取出区域中的连续特征,苹果研究人员提出一种空间感知的视觉采样器,它能处理不同形状多种稀疏性。这也使Ferret可以接受多样化区域输入,像是点、边界框、自由形式的形状。

为提升Ferret的能力,苹果团队使用了GRIT数据集(Ground-and-Refer Instruction-Tuning),后者为是一个广大的refer-and-ground指令微调数据集,包含110万个样本,内有丰富的阶层化空间知识,以及9.5万个负样本,以提升模型的判断力。

与Kosmos-2、GPT4-ROI、LLaVA、Shikra等多模态大语言模型比较,最后苹果得到的模型Ferret-13B,在传统引用及定位任务具有优异效能,此外,在区域为基础、需要本地化的多模态对话、细节描述,以及复杂推理等任务上,Ferret-13B的表现同样优于其他模型。在视觉化比较任务,苹果说它的模型展现优异的空间理解及常识推理能力。此外,苹果宣称其物件幻觉也较Shikra、InstructBLIP、MiniGPT4、LLaVA、MM-GPT及 mPLUG-Owl等知名模型少很多。

苹果公布了Ferret7B、130B二模型的 代码、GRIT数据集、标竿测试工具Ferret-Bench,上周也公布了Ferret 70B及130B检查点(checkpoint)。

有趣的是,在人工智能社区中,很多人都是到最近才发现苹果的大模型,Bart de Witte也在X上感叹自己居然错过了这个消息,同时也表示:“期待着有一天,本地大型语言模型能作为重新设计的iOS的集成服务,运行在我的iPhone上。”

随着苹果大模型的开发有了新的进展,Anthropic和OpenAI据称也在为其专有大语言模型的开发工作谈判新的巨额融资。

津公网安备12011002023007号

津公网安备12011002023007号