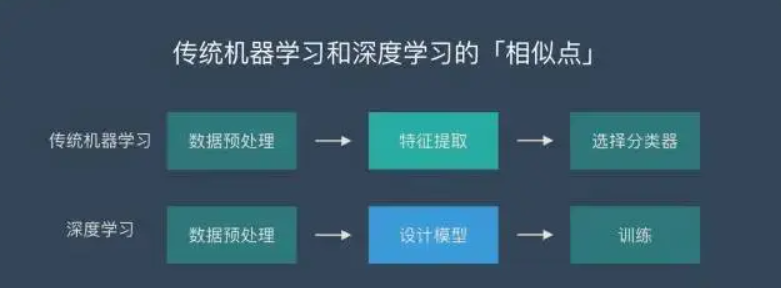

总的来说,下面的这些方法都是建立在深度学习的基础上的,与常规的机器学习有着一定的不同:

那就是两件事情。

手工特性抽取-自动化特性抽取

而深度学习最大的特点,就是它可以自主的从数据中抽取数据,强大的计算能力,让它可以处理人类做不到的事情。实现了自动控制后,机器人具有更好的学习和适应能力。

对产生的效果进行手工判定–进行自动化判定和最优化,而在学习中,由于使用了很多的手工标记,使得该方法代价高昂,而且效果不佳。而由人来判定产生的效果的优劣,则存在着费用高昂、效果低下的问题。

AI 绘画平台基于一些目前非常火热的 AI 绘画算法,就是用不同的算法策略实现以上两点,如下:

1)技术

一句话来概括 GAN 的设计动机就是——自动化。

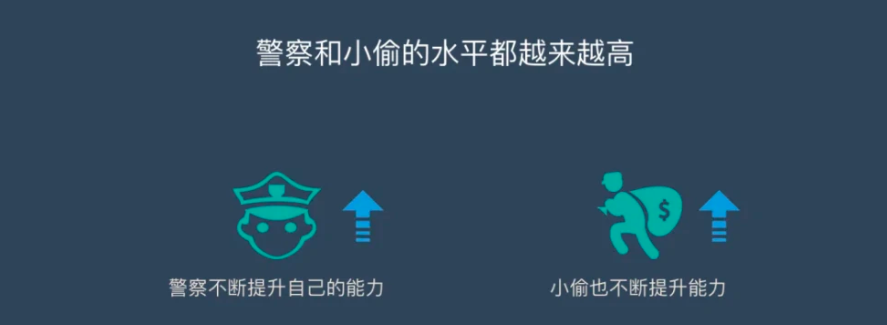

生成对抗网络()是一种非常流行的 AI 绘画算法。它包含两个网络:生成器和判别器。生成器生成图像,而判别器则评估图像的真实性。

两个网络在训练过程中相互竞争,直到生成器可以生成与真实图像相同的图像为止。

知乎上有一个很不错的大白话解释,大家应该都能理解:起初一座城市治安不好,许多高低水平的小偷都混入其中;突然开启了一场整顿治安的活动,低水平的小偷很快就被抓住了,于是整体的小偷水平大大提高;之后警察也自我提升能力,通过抓住一个个高水平的小偷案例,练就了一眼看出小偷并及时制止的能力,经常的水平耶大大提高了;两者就这样反复“对抗“,最终同时得到了最强的小偷和最强的警察。

非大白话解释就是控制变量训练,固定判别器,训练生成器去“骗过”判别器;再固定生成器,训练判别器找出生成器做的“假数据”;以此往复循环训练。

最后,我们获得了一个“生成器 G”,其结果是,我们能够使用这个工具来产生所需的图像。

想了解 GAN技术的细节,请阅读以下两个部分:

近年来,它已被应用来产生真实的图像,视频,音频等。

一种以人工智能为基础的绘图方法为

这是一个人工智能技术为基础的美术创造,运用 GAN实现了极高的真实感。使用 ArtBreeder,使用者可以制作出令人目眩神迷的作品。举例来说,使用者可以先选取一张人脸,再选取其他人脸的眼与口来建立新人脸。利用这些技术产生的效果是如此的真实,以至于难以辨别它们的真伪。这给了艺术家一种崭新的艺术创造手段。

以 GAN为基础的技术:

是一种将一组影像资料转化为另外一组影像资料的一种算法。该方法采用了一种新的 GAN算法,采用了两个发生子和两个区分子的方法,完成了对图像的变换。循环 GAN可以被用来把一种类型的美术转化为另外一种类型的美术,或者把图片转化为油画,等等。

其中一个主要的用途就是“域变换”,也就是“场景变换”,可以将一幅画变成梵高,也可以将一幅画变成现实,也可以将一幅画变成现实。

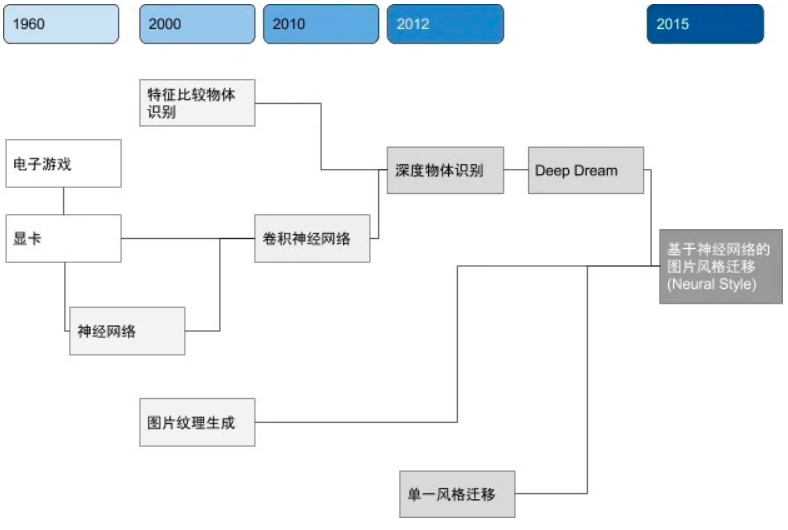

2)风格迁移技术

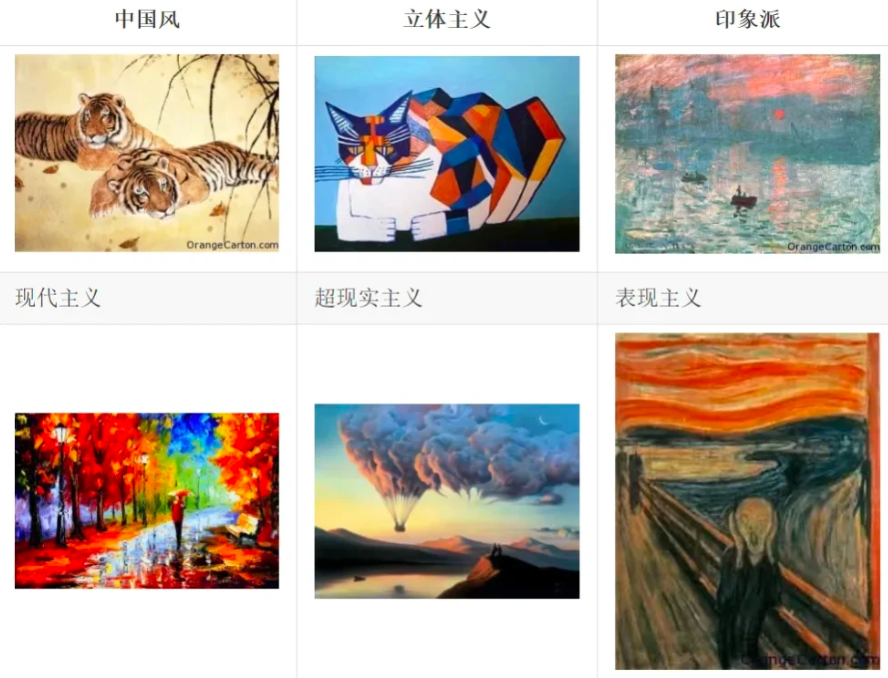

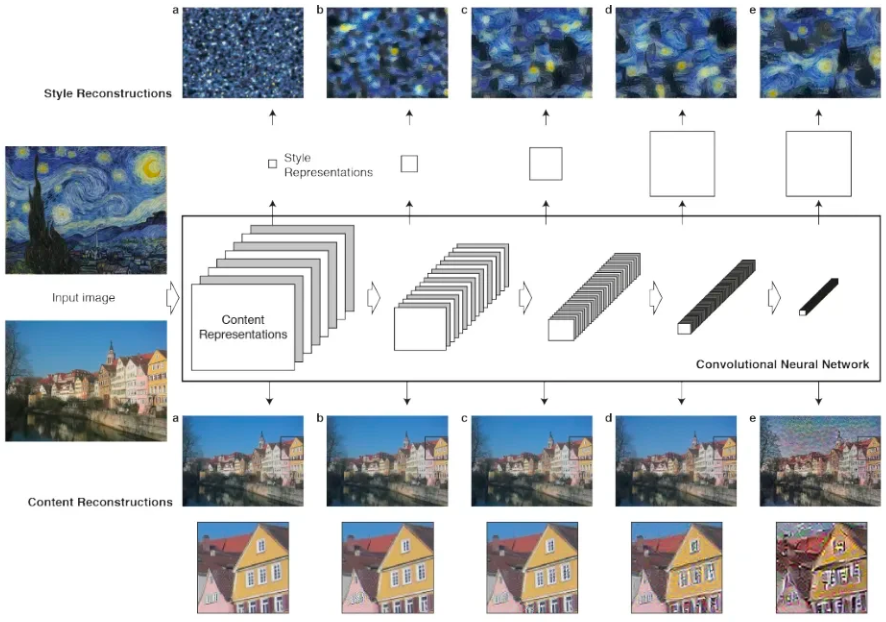

风格迁移是一种将一个图像的艺术风格应用到另一个图像上的算法。它基于卷积神经网络(CNN),可以将输入图像分解为不同的层和通道,然后将每一层和通道的特征图与目标风格的特征图进行比较。最近,风格迁移已经被用于生成独特的艺术作品,包括与现实世界不同的 3D 场景、动漫图像等。

比如以下每一张图都是一种不同的艺术风格:

有些东西大概艺术界也没明确的定义,如何要把一个图像的风格变成另一种风格更是难以定义的问题。在神经网络之前,图像风格迁移的程序有一个共同的思路:分析某一种风格的图像,给那一种风格建立一个数学或者统计模型,再改变要做迁移的图像让它能更好的符合建立的模型。这样做出来效果还是不错的,比如下面的三张图中所示,但一个很大的缺点:一个程序基本只能做某一种风格或者某一个场景。因此基于传统风格迁移研究的实际应用非常有限。

改变了这种现状的是两篇 Gatys 的论文,在这之前让程序模仿任意一张图片画画是没法想象的。

从纹理到图片风格其实只差两步。第一步也是比较神奇的,是 Gatys 发现纹理能够描述一个图像的风格。严格来说文理只是图片风格的一部分,但是不仔细研究纹理和风格之间的区别的话,乍一看给人感觉还真差不多。第二步是如何只提取图片内容而不包括图片风格。这两点就是他的第二篇论文做的事情:Gatys 又偷了个懒,把物体识别模型再拿出来用了一遍,这次不拿 Gramian 算统计模型了,直接把局部特征看做近似的图片内容,这样就得到了一个把图片内容和图片风格(说白了就是纹理)分开的系统,剩下的就是把一个图片的内容和另一个图片的风格合起来。合起来的方法用的正是之前提到的让神经网络“梦到”狗的方法,也就是研究员们玩出来的 Deep Dream,找到能让合适的特征提取神经元被激活的图片即可。

3)自适应生成

自适应生成是一种使用对抗性损失和重建损失来训练生成器的算法,它可以生成新的数据样本,例如图像、文本、音频等等。它的目标是通过学习输入数据的特征分布,生成与输入数据类似的新数据。

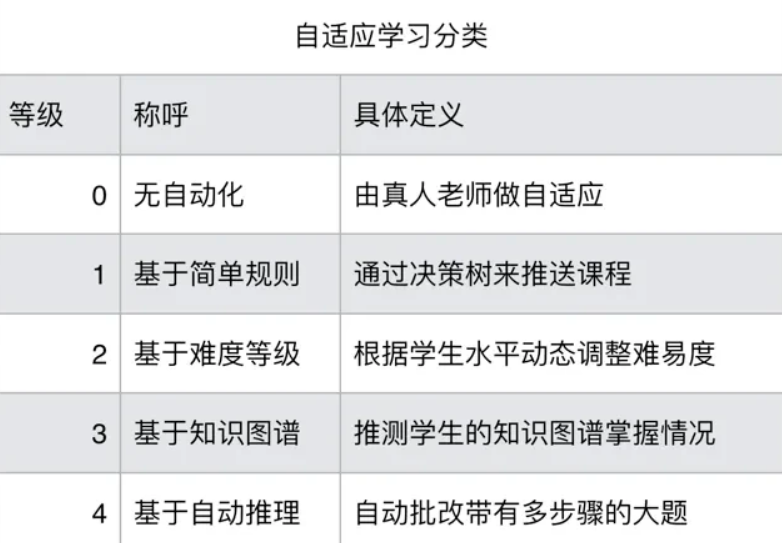

自适应生成算法的基本思想是建立一个生成模型,该模型可以学习输入数据的概率分布,并在学习过程中调整模型参数以最大限度地减少生成数据与真实数据之间的差异。这样,模型就能够生成与输入数据类似的新数据。其有以下分类:

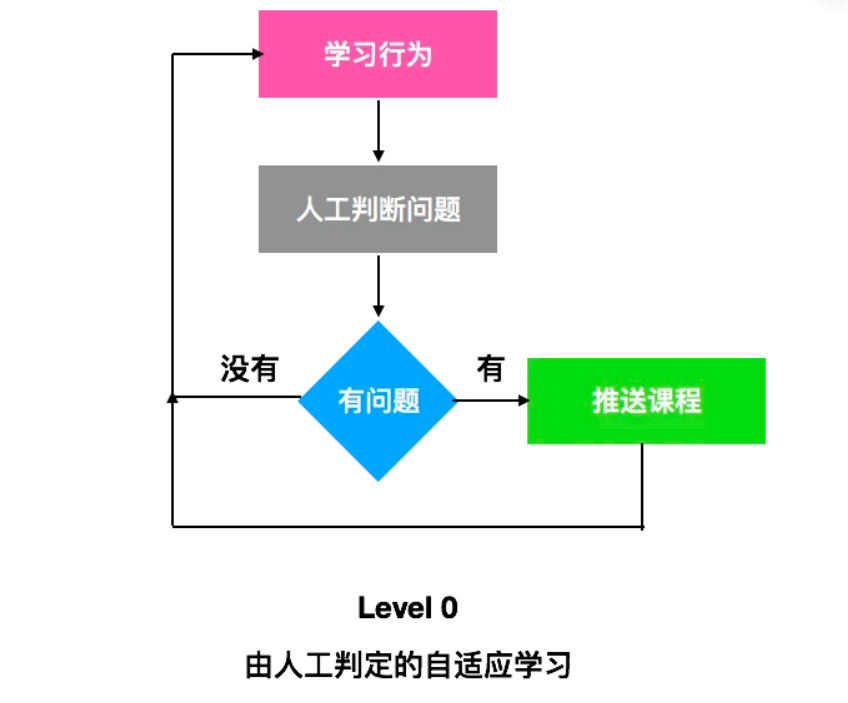

最简单的例子:如果要做一款自适应学习的产品,我们先假设电脑是完全没有能力判断出学生的能力水平,而由老师来做判断,判断之后,由电脑来推送相应的课程。

举例:英语作文批改

用户在网站上录入了自己的托福作文,提交后,作文被送到一个队列里等待人工的批注。老师收到了新的作文后,对学生作文的各个部分进行标注,哪些单词拼错了,用错了,哪些固定搭配错了,哪些语法有问题,文章结构有什么问题。批改完毕后,学生会收到老师的评价,和系统自动推送出的单词,语法,和结构课。从算法上来讲,逻辑很简单,总共会有不同的几种错误类型,和对应的课程,只要学生在作文里出现某种错误,就自动推这类课程。外,最著名的自适应生成算法是生成对抗网络(GAN)。它可以学习艺术家的风格和技巧,然后生成新的艺术作品。自适应生成可以用于生成逼真的肖像、风景画和动漫角色等。

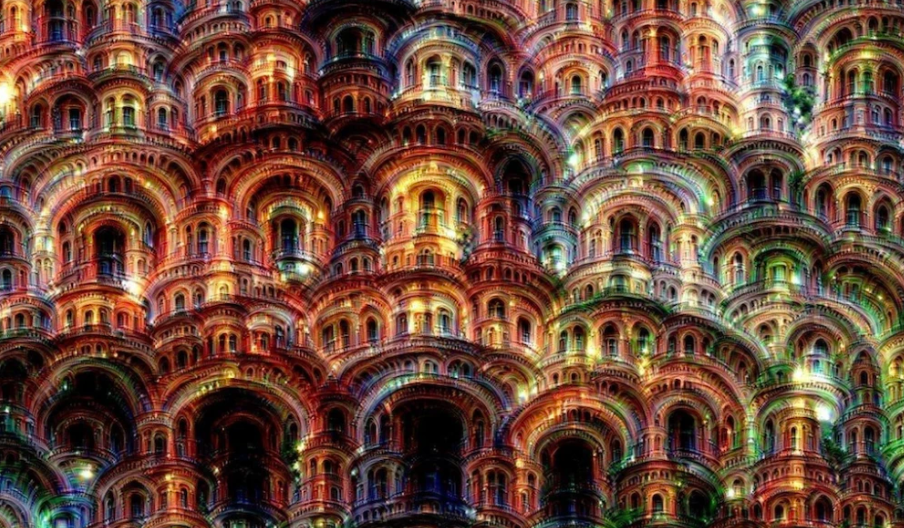

4)DeepDream 算法

通过将深度神经网络的激活函数反向传播,生成幻觉般的图像。此算法可以生成下面的图片:

首先,在卷积神经网络(简称 CNN)的研究中,大家并不满足于精准的图片分类,还想知道网络中各层乃至各个神经元都学习到了什么东西。如果能将每一个神经元的内容可视化出来,将是十分有用的。

那么如何对 CNN 中的某一神经元进行可视化呢?

Deep Dream 的想法就是:学习出一张图片,使得这一神经元能够产生最大激活。从数值上看,就是使得这一神经元的输出值最大。

更一般的,不仅可以最大化某一个神经元的输出,还可以最大化一组神经元的输出,或者某一层的总输出。这样得到的是多个神经元的混合可视化结果。因此,Deep Dream 是基于训练好的卷积神经网络进行图片的生成,在生成图片时,神经网络是冻结的,也就是网络的权重不再更新,只更新输入图片。

津公网安备12011002023007号

津公网安备12011002023007号