自从2022年底open AI推出ChatGPT开始,大型语言模型(LLMs, Large Language Models)的热度吸引了全世界的眼球,相关研究也取得了令人瞩目的进展。除了纯语言模型相关的技术研究以外,将视觉能力融入大语言模型的视觉语言模型(VLMs,Vision Language Models)也迅猛发展。

目前市场上主流的研究路线主要分为两种:1)原生多模态路线,模型设计从一开始就针对多模态数据进行适配,代表性的工作有微软的KOSMOS系列和Florence系列、谷歌的PALM-E系列,以及阿里的OFA系列等;2)将单模态特征作为LLMs的额外输入tokens来扩展语言模型,从而将其用于视觉语言等多种任务中,代表性的工作有Deepmind的Flamingo、Saleforce的BLIP-2、LLAVA,以及阿里的Qwen-vl等。

以上两种技术路线各有优劣,原生多模态路线的模型结构主体均为Transformer的基础堆叠,包括encoder和decoder两个模块;而视觉模块作为语言模块额外输入补充的方式多为decoder-only的模型架构、transformer LLMs模型作为中心,其他模态的模型作为外围辅助特征提取模块,用小参数量的模型就可以做到各个单模态领域已有成果的复用,同时还能保留LLMs的已有效果,通过插入多个对齐层来实现视觉信息与文本信息的对齐和联合学习,这种方式在扩展模态信息上也更灵活。用同样的方法可以支持语音、图片、视频等其他模态数据的统一训练。

01 总述

考拉悠然在视觉以及多模态领域有超过20年的技术积累,拥有20余项世界*的技术突破,大模型时代到来以后,公司*时间投入到多模态大模型的研发工作,经历了多个版本迭代,于11月15 日正式发布了悠然多模态产业通用大模型应用与服务平台。

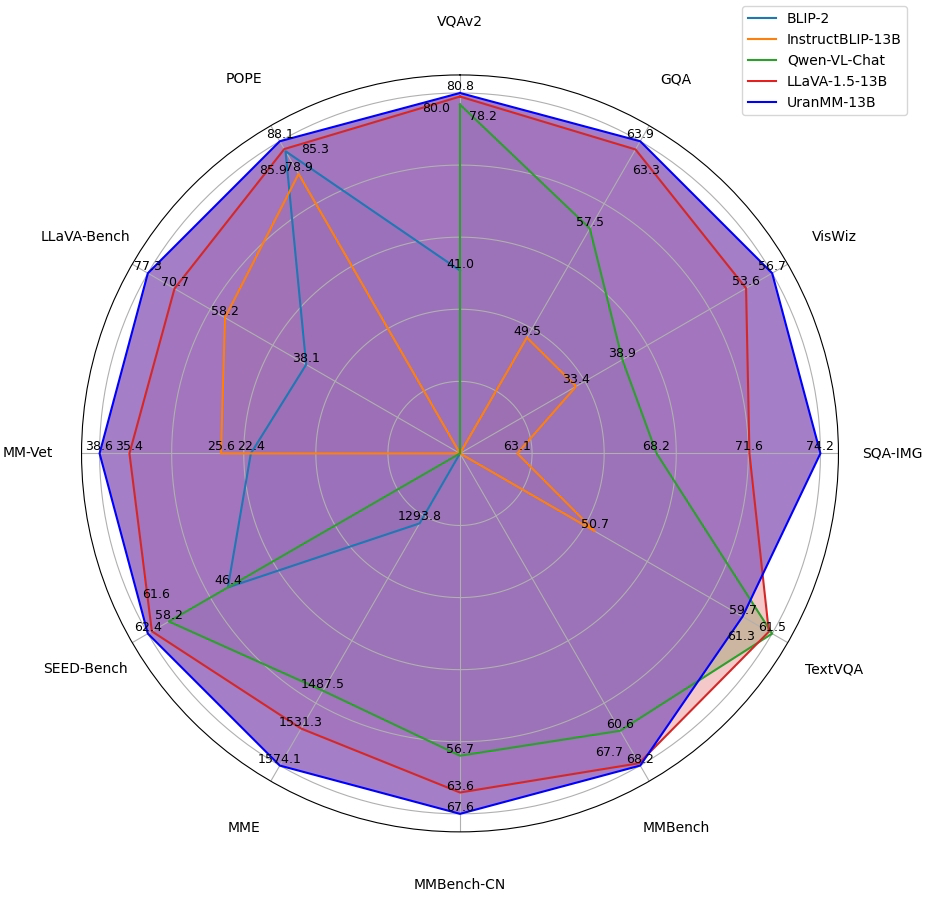

悠然大模型(以下简称UranMM-13B)采用先进的多模态大模型架构,将视觉等模态知识作为模态数据补充到LLMs,简单高效地扩展了LLM的识图、视频理解等跨模态能力,作为一种多模态视觉语言大模型,悠然大模型具有*的图文理解、视频理解、多模态推理等能力,并且保留了常见的自然语言任务处理能力,包括问答、信息检索、创意写作和辅助编码等能力。该模型对比BLIP2、LLaVa、QwenVL-Chat等国内外模型评测的打分中,表现出不俗的成绩。同时,悠然大模型定位为产业通用大模型,基于产业模型可以快速生成行业模型,结合行业应用发挥出更大的价值。

02 模型介绍

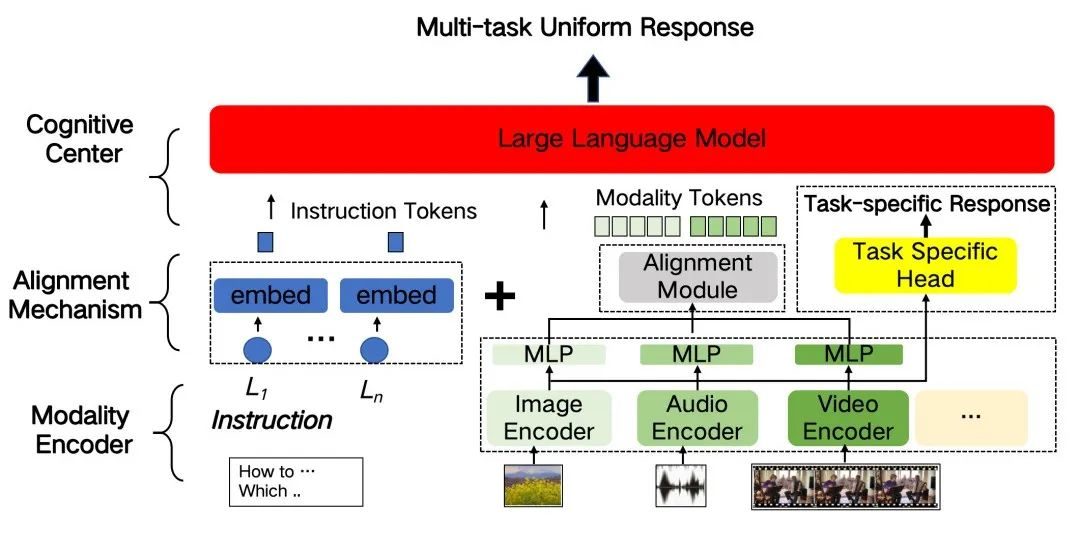

模型结构

整个模型主要由多模态编码器、对齐模块、大语言模型三个模块组成,结合了高质量场景化数据,通过控制可训参数进行预训练和调优。

● 多模态编码器:以视觉编码器(Image Encoder)为例,UranMM-13B使用了预训练的CLIP ViT-L/14,以提取输入图像的特征。图像被调整为336×336的统一尺寸,并被分割成14个步长的patch,最终转化为序列长度为576的tokens作为LLMs的输入。

● 对齐模块:使用了一个多层感知器MLP,用于与LLMs模型理解的知识结构匹配。

● 大语言模型:UranMM-13B 以LLaMa2为基础,具备13B参数量,特别进行了中文分词优化,增加了200B tokens具备行业属性的中英文数据进行预训练,在中文、英文、数学、代码等下游任务上,相对于Llama2-13B取得了明显的提升。

训练数据

现有的多模态公开指令集,存在质量偏低和数量有限的问题,通过公开数据训练出来的模型存在严重幻觉,无法满足实际应用需求。为此,考拉悠然研发团队采用了一系列高质量数据生成策略:

1. 基于主流的视觉和语言大模型设计规则,对公开数据进行清洗和过滤,得到*部分高质量的种子数据,根据实际经验判断数据的有效率约30%。

2. 结合GLIP、SAM、KOSMOS等先进视觉技术,采用粗粒度信息和细粒度信息的抽取,将图像描述转化为语言形式,再通过模型构建一批高质量的指令数据。

最终用于模型训练的数据规模达到了百亿token全模态数据,和百万行业高质量指令集。

训练方法

训练方法上,考拉悠然取得了许多创新成果,团队基于DeepSpeed的训练框架进行优化,采用BF16精度,整合了FlashAttention2等技术提升训练效率。

同市场上很多VLM模型的生成过程类似,悠然大模型训练过程分为两个阶段:*阶段使用图像-文本数据训练视觉和语言模型对齐层,使视觉模型抽取出来的图像特征能够和LLM中的文本特征空间进行对齐;第二阶段使用行业自有指令数据和开源指令数据,进一步微调模型的视觉感知以及业务理解能力,同时,为了保持模型语言能力的稳定性,还使用了ShareGPT的1M文本数据。

UranMM-13B还特别针对实际业务场景的需求,实现了预测场景的能力强化。我们使用了分组查询注意力(GQA)进行更快的推理、滑动窗口注意力(SWA)以更低的成本处理更长的序列,这些技术使模型更好地处理时间序列预测问题,实现更精准的预测。我们的模型还具备自我学习和调整的能力,能够根据新的数据和反馈持续优化预测结果。

03 评测结果

UranMM-13B在视觉标注、问答、关联提取等任务中,与近期的SOTA模型相比取得了*的效果。

UranMM-13B与近期的SOTA模型评测对比图

04 通用能力展示

图片识别

以下为真实交通场景下,对图片多目标的类型与特征进行识别的案例。

OCR

以下案例展示了模型执行实际街道照片的中文OCR识别任务的能力。

文本写作

以下案例展示了模型基于灾害场景的图片信息的文本创作能力。

05 真实业务场景示例

基于悠然多模态产业通用大模型,经过行业数据微调构生成行业大模型后,配合模型推理训练引擎、向量数据库、多模态数据实时加工服务与Agent智能体等大模型应用工具链,可以快速构建各类行业AI应用。这一最新的应用范式,对比过往的产品解决方案,在业务效果和交付效率层面均有显著的提升,有望催生全新的行业AI原生应用,实现产业真正的智能化升级。在高空交通监管、电网巡检、半导体质量检测、烟草生产管控、智慧城市治理等交通、能源、工业、政务领域的场景中拥有广阔的应用空间与大量潜在商机。

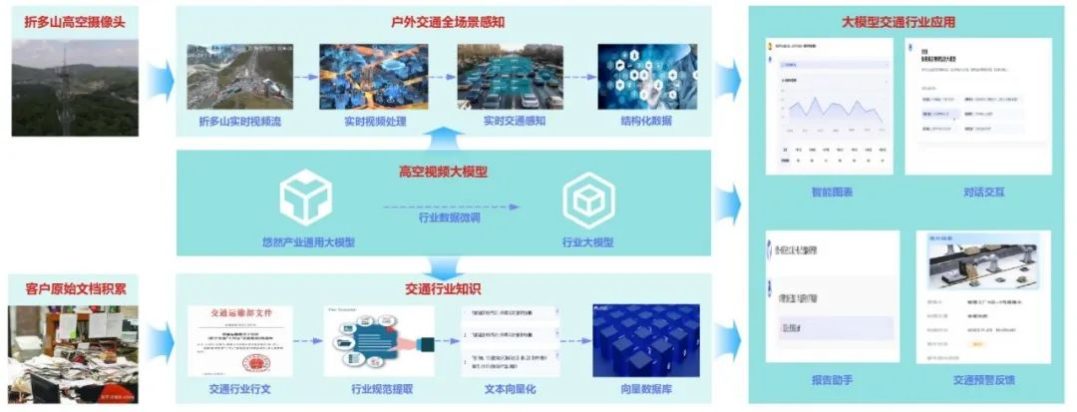

以下以高空交通监管场景的行业应用功能点为例,展示模型在真实业务场景中的应用效果。

高空视频大模型 + 高空视频全要素感知预警平台

以川藏公路折多山当地的交通感知预警应用为例。一方面,当地部署的多个高空摄像头,24小时实时传输道路视频流。视频流在经过高空视频大模型驱动的数据处理服务加工后,形成动态增删的结构化的事件数据集;另一方面,业务方预先准备的《中华人民共和国道路交通安全法》《中华人民共和国道路交通安全法实施条例》及四川交通厅相关道路安全行政法规等行业规范,构建了完备的行业知识库。

当出现紧急情况时,行业智能体将结合视频事件与行业法规条例的信息,智能判断告警程度并输出事件分析报告,协助监管人员及时处理险情。在日常运营时段,监管人员也可以实时通过预警平台,灵活生成指定时段的交通动态图表、分析报告,为监管工作提供敏捷可靠的数据支撑。

上述案例充分展现出悠然多模态产业通用大模型,在视觉识别、信息理解、逻辑推断、知识应用等任务上的良好效果。

津公网安备12011002023007号

津公网安备12011002023007号