算力、能耗双双发出警报。

算力是AI世界发展的基础,而算力的瓶颈归根到底还是电力,ChatGPT等AI大模型训练起来到底多费电?

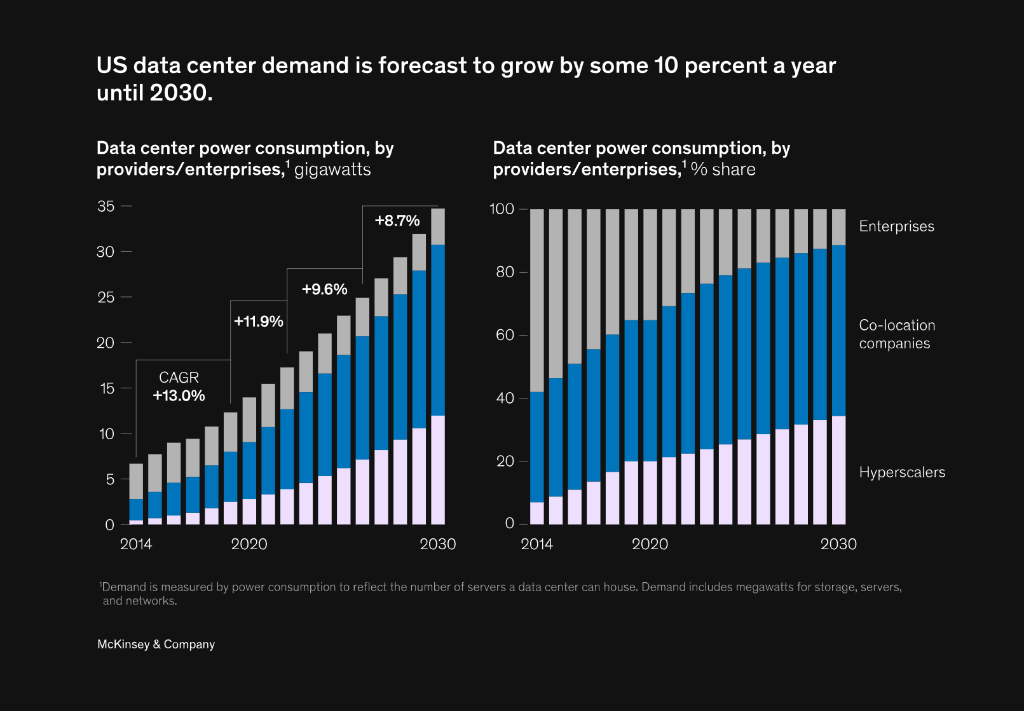

7月15日,根据Digital Information World发布的最新报告,数据中心为训练AI模型产生的能耗将为常规云工作的三倍,预计到2030年,美国数据中心的电力需求将以每年约10%的速度增长。

数据显示,OpenAI训练GPT-3耗电为1.287吉瓦时,大约相当于120个美国家庭1年的用电量。而这仅仅是训练AI模型的前期电力,仅占模型实际使用时所消耗电力的40%。

2023年1月,OpenAI仅一个月已耗用可能等同17.5万个丹麦家庭的全年用电量。谷歌AI每年耗电量达2.3太瓦时,相当于亚特兰大所有家庭1年用电量。

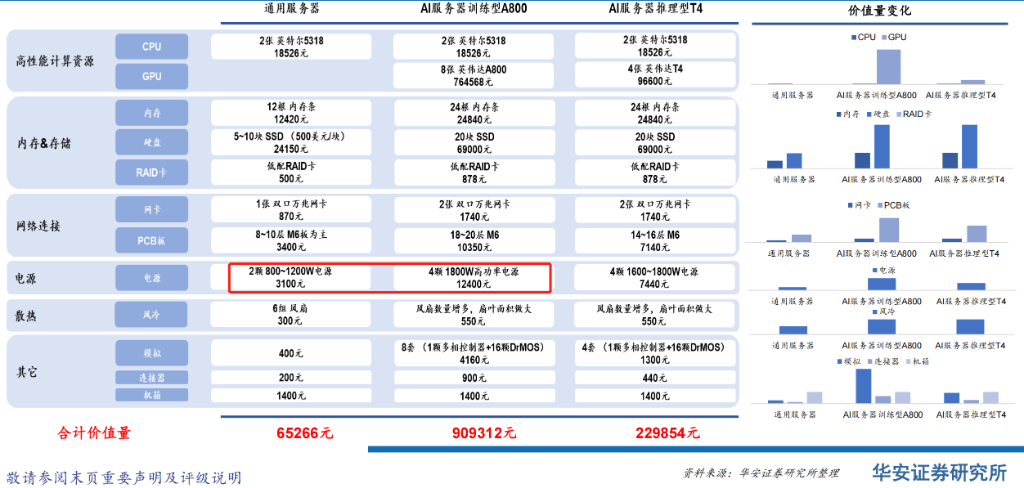

据了解,AI服务器的功率较普通服务器高6-8倍,这对于电源的需求也将同步提升,通用型服务器原来只需要2颗800W服务器电源,而AI服务器的需求直接提升为4颗1800W高功率电源,服务器能耗成本直接3100元直接飙升到12400元,大涨3倍。

数据中心客户为此支付的电费也更为高昂。市场研究公司Synergy Research Group的首席分析师John Dinsdale坦言,数据中心运营商正将运行AI应用程序产生的额外成本直接转嫁到客户身上。

一些数据中心的运营商们趁机提高商业租赁价格,以应对为运行日益能源密集型工作负载的计算机服务器组群(stack)供电和散热而产生的额外成本。

据全球最大商业房地产服务公司之一的世邦魏理仕(CBRE Group)统计,数据中心客户囊括了小型企业到大型云服务供应商,目前消耗电力的速度快于数据中心运营商扩展容量的速度。由于人工智能用例的增加,供应限制日益严重,这为数据中心收取的价格带来了上行压力。

在强大的电力需求下,据世邦魏理仕统计,今年前三个月,美国北弗吉尼亚州的数据中心客户每月每千瓦电力支付的费用高达140美元,比一年前的130美元增长了7.7%。

“吃电”的大模型

据咨询机构Tirias Research建模预测,到2028年数据中心功耗将接近4250兆瓦,比2023年增加212倍,数据中心基础设施加上运营成本总额或超760亿美元。

这堪称“生成式AI颠覆数据中心”,其增长对新兴服务(例如搜索、内容创建和结合生成式AI的业务自动化)的商业模式和盈利能力都提出了挑战,成本更是亚马逊AWS年运营成本的两倍多。

这堪称“生成式AI颠覆数据中心”,其增长对新兴服务(例如搜索、内容创建和结合生成式AI的业务自动化)的商业模式和盈利能力都提出了挑战,成本更是亚马逊AWS年运营成本的两倍多。

该机构称,生成式AI带来的种种创新功能,都是以处理性能和功耗方面的高昂成本为代价。因此,虽然人工智能的潜力可能是无限的,但物理和成本最终可能是界限。

为了降低成本,该机构建议,可使用高度优化、甚至是更简单、更专业的小型神经网络模型来降低数据中心成本,方法是减少云端的模型规模,将海量参数网络用于快速训练较小的模型,并将工作负载完全移出云端,从而将生成式AI应用程序更加经济高效地分发给智能手机、PC、车辆和移动XR产品等分布式平台上运行:

“五年前,各公司在年度Hot Chips半导体技术会议上开始对数据中心功耗敲响警钟,当时预测全球计算需求可能在十年内超过全球发电总量。那还是在生成式AI迅速采用之前,而生成式AI有可能以更快的速度增加计算需求。

天下没有免费的午餐——消费者会要求更好的生成式AI输出,而这将抵消效率和性能的提升。随着消费者使用量的增加,成本将不可避免地攀升。将计算转移到边缘,并将其分配给PC、智能手机和XR设备等客户端是降低资本和运营成本的关键途径。”

“五年前,各公司在年度Hot Chips半导体技术会议上开始对数据中心功耗敲响警钟,当时预测全球计算需求可能在十年内超过全球发电总量。那还是在生成式AI迅速采用之前,而生成式AI有可能以更快的速度增加计算需求。

天下没有免费的午餐——消费者会要求更好的生成式AI输出,而这将抵消效率和性能的提升。随着消费者使用量的增加,成本将不可避免地攀升。将计算转移到边缘,并将其分配给PC、智能手机和XR设备等客户端是降低资本和运营成本的关键途径。”

如今全球范围内群模大战,需要消耗的能源和产生的碳排放体量之巨大,可以想见。

按照当前的技术路线和发展模式,AI进步将引发两个问题:一方面,数据中心的规模将会越来越庞大,其功耗也随之水涨船高,且运行越来越缓慢。

另一方面,AI芯片朝高算力、高集成方向演进,依靠制程工艺来支撑峰值算力的增长,制程越来越先进,其功耗和水耗也越来越大。并且,受摩尔定律约束,传统计算能力已接近极限,面临冯·诺依曼架构瓶颈、物理微缩的挑战。

这两个问题都将导致AI能耗问题愈加严重。

打响电力争夺战

庞大的电力需求无疑将进一步对数字基础设施造成压力,现有的数据中心已无法满足AI日益增长的电力需求。

去年,位于北弗吉尼亚的数据中心一度面临停电危机,能源问题迫在眉睫。

为了解决AI能耗日益上涨的问题,数字基础设施公司DigitalBridge正计划投入数十亿美元建设并翻新用于生成式AI工作负载的数据中心。

Digital Information World认为,下一代数据中心将比当前弗吉尼亚及圣克拉拉市的数据中心配套设施更加全面。选址应当位于电力供应不成问题的低成本地区,为了满足AI的算力需求,数据中心运营商必须适应并采用新颖的解决方案。

随着争夺AI军备竞赛日趋白热化,对电力的争夺变得越来越重要。

“生成式AI颠覆数据中心”,电力需求对各大公司的商业模式和盈利能力都提出了挑战。生成式AI带来的种种创新,都是以处理性能和功耗方面的高昂成本为代价。

因此,虽然人工智能的潜力可能是无限的,但物理和成本最终可能是界限。各大科技公司们正在尝试一切可能的策略来确保电力需求,为变革性的能源未来奠定基础。

津公网安备12011002023007号

津公网安备12011002023007号